AI не экономит время – он его уплотняет: 8 месяцев наблюдений

Компании беспокоятся, как заставить сотрудников использовать AI. Обещание соблазнительное: AI возьмёт на себя рутину – черновики документов, суммаризацию информации, отладку кода, – освободит время для высокоценных задач.

Но готовы ли компании к тому, что произойдёт, если они в этом преуспеют?

Исследователи из Стэнфорда провели 8-месячное наблюдение за примерно 200 сотрудниками американской технологической компании, которая внедрила генеративный AI. Компания не требовала использовать AI принудительно, просто предоставила корпоративные подписки на коммерческие инструменты. Сотрудники сами решали, применять AI или нет.

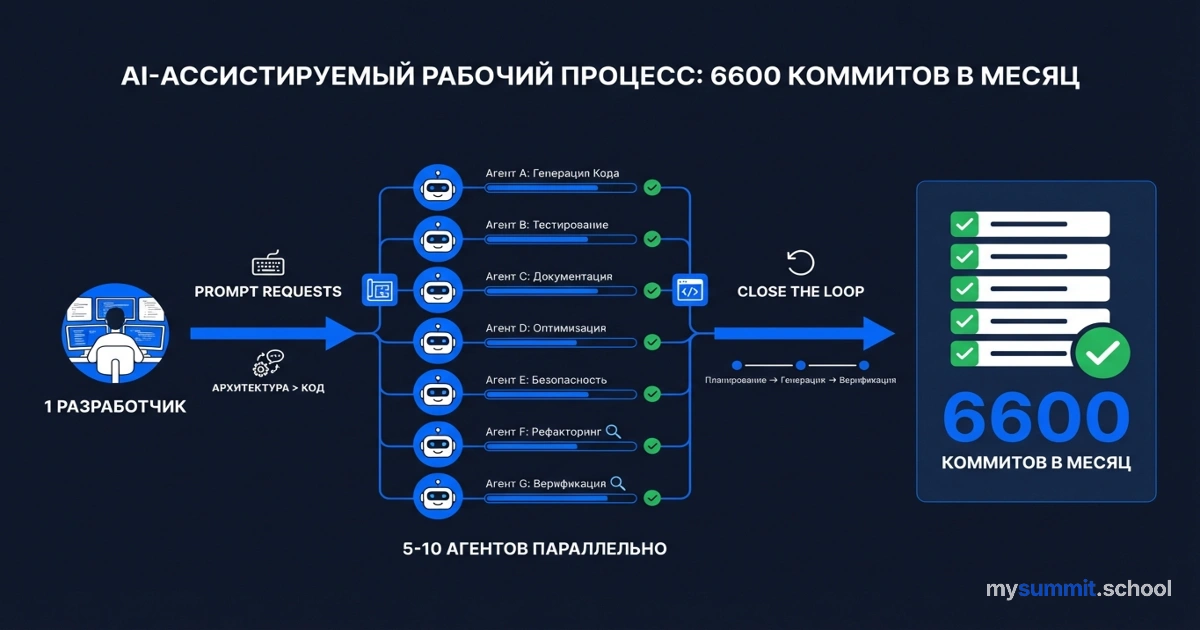

Результат оказался парадоксальным. AI не сократил работу. Он её интенсифицировал. Работники стали работать быстрее, брать на себя больший объём задач, распространять работу на большее количество часов в день – часто без явных внешних требований. AI сделал “делать больше” возможным, доступным и во многих случаях внутренне награждающим.

Удивительно, но тот же паттерн прослеживается в других исследованиях. Microsoft обнаружил, что 62% продакт-менеджеров используют Gen AI ежедневно, но 81% говорят, что AI экономит время, при этом 56% отрицают, что усилий стало меньше. Парадокс? Нет, закономерность.