ChatGPT в онлайн-школе: проверка эссе дала 47% галлюцинаций

82% EdTech-компаний в 2024-2025 годах тестировали ChatGPT для автоматизации проверки работ студентов, но только 14% продолжили использовать его в продакшне – по данным исследования HolonIQ. Остальные 68% отказались после пилота из-за галлюцинаций и жалоб преподавателей.

В сентябре 2024 года я запустил эксперимент в нашей онлайн-школе: ChatGPT проверяет эссе студентов курса по digital-маркетингу. 120 работ в неделю, каждая – 800-1200 слов. Ожидали освободить 15 часов времени преподавателя. Реально получили 47% ответов с фактическими ошибками и галлюцинациями.

Парадокс: модель отлично оценивала структуру текста и грамматику, но полностью проваливалась на проверке фактов. “Отличная аргументация, 9/10” – написала про эссе, где студент выдумал три несуществующих исследования Gartner и цитату Илона Маска, которую тот никогда не говорил.

В этой статье – честный разбор того, что сработало, а что провалилось при внедрении AI в образовательный процесс. С реальными метриками, стоимостью ошибок и выводами.

Как я внедрял ChatGPT для проверки студенческих работ

Исходная задача

В онлайн-школе у нас было 340 активных студентов на курсе по digital-маркетингу. Каждую неделю – 120 эссе по 800-1200 слов. Преподаватель Анна тратила на проверку:

- Чтение и оценка: 12-15 минут на одно эссе

- Написание фидбека: 5-7 минут

- Итого: ~18 часов в неделю только на проверку

Нагрузка нарастала, качество фидбека падало, Анна выгорала.

Гипотеза: ChatGPT может проверять эссе за 2-3 минуты каждое, освободив 80% времени преподавателя для персональных консультаций.

Что я сделал (технически)

Создал систему на Python, которая:

- Забирает эссе из LMS (Moodle)

- Отправляет в ChatGPT с подробным промптом

- Получает оценку и развернутый фидбек

- Сохраняет результаты обратно в LMS

Промпт для проверки эссе (упрощенная версия):

| |

Метрики первой недели эксперимента:

- Проверено эссе: 120

- Время на одно эссе: 2,5 минуты (vs 18 минут вручную)

- Общее время: 5 часов (vs 36 часов у преподавателя)

- Стоимость API: 340₽ (gpt-4o-mini, ~3000 токенов на эссе)

Казалось бы, успех! Но потом начались проблемы.

Три сценария, где ChatGPT реально сработал

Не все было плохо. Вот задачи, где модель показала себя хорошо:

Сценарий 1: Проверка структуры и форматирования

Задача: Студенты часто сдавали эссе без введения, без заключения, с нарушенной логикой абзацев.

Результат:

- ChatGPT выявлял структурные проблемы в 94% случаев

- Давал конкретные рекомендации: “Отсутствует вводный абзац”, “Третий и четвертый абзацы стоит поменять местами”

- Преподаватель подтвердил точность в 89% случаев (проверили выборку из 50 эссе)

Экономия времени: 3-4 минуты на каждое эссе – больше не нужно вручную проверять структуру.

Сценарий 2: Оценка языка и стиля

Задача: Проверить грамотность, читабельность, отсутствие канцелярита.

Результат:

- Модель находила грамматические ошибки, которые пропускал даже преподаватель

- Указывала на сложные конструкции и канцелярит

- Давала примеры улучшения формулировок

Точность: 91% (сравнили с ручной проверкой)

Важно: Для этой задачи достаточно gpt-4o-mini, не нужна дорогая модель.

Сценарий 3: Генерация шаблонных комментариев

Задача: Частые ошибки (нет примеров, слишком общие формулировки, нет ссылок на источники).

Что сделали:

- Создали базу из 15 типовых ошибок

- ChatGPT подбирал подходящие комментарии и персонализировал их под конкретное эссе

Результат:

- 70% фидбека генерировалось автоматически

- Преподаватель дописывал только персональные рекомендации (3-5 минут)

- Студенты не жаловались на “роботизированность” – комментарии были контекстные

Общая экономия по трем сценариям: ~10 часов в неделю преподавателя.

Где ChatGPT провалился: три дорогих ошибки

А теперь честно про провалы. Именно они заставили нас пересмотреть всю стратегию.

Провал 1: Галлюцинации при проверке фактов

Что случилось:

Студент написал эссе про “тренды digital-маркетинга в 2024 году”. В тексте:

- Цитата Илона Маска про эффективность TikTok-рекламы

- Ссылка на исследование Gartner “Digital Marketing Trends 2024”

- Статистика: “87% компаний увеличили бюджеты на контент-маркетинг”

ChatGPT дал оценку 9/10: “Отлично аргументированное эссе с актуальными данными и цитатами экспертов.”

Реальность:

- Илон Маск никогда такого не говорил (я проверил через поиск)

- Исследования Gartner с таким названием не существует

- Статистика выдумана

Масштаб проблемы:

- Из 120 проверенных эссе 56 содержали выдуманные данные (47%)

- ChatGPT не выявил ни одной галлюцинации

- Более того: хвалил студентов за “хорошее использование источников”

Стоимость ошибки:

- 23 студента подали жалобы на несправедливые оценки

- Пришлось перепроверять все 120 работ вручную = 36 часов преподавателя

- Репутационный ущерб: “школа ставит оценки через робота”

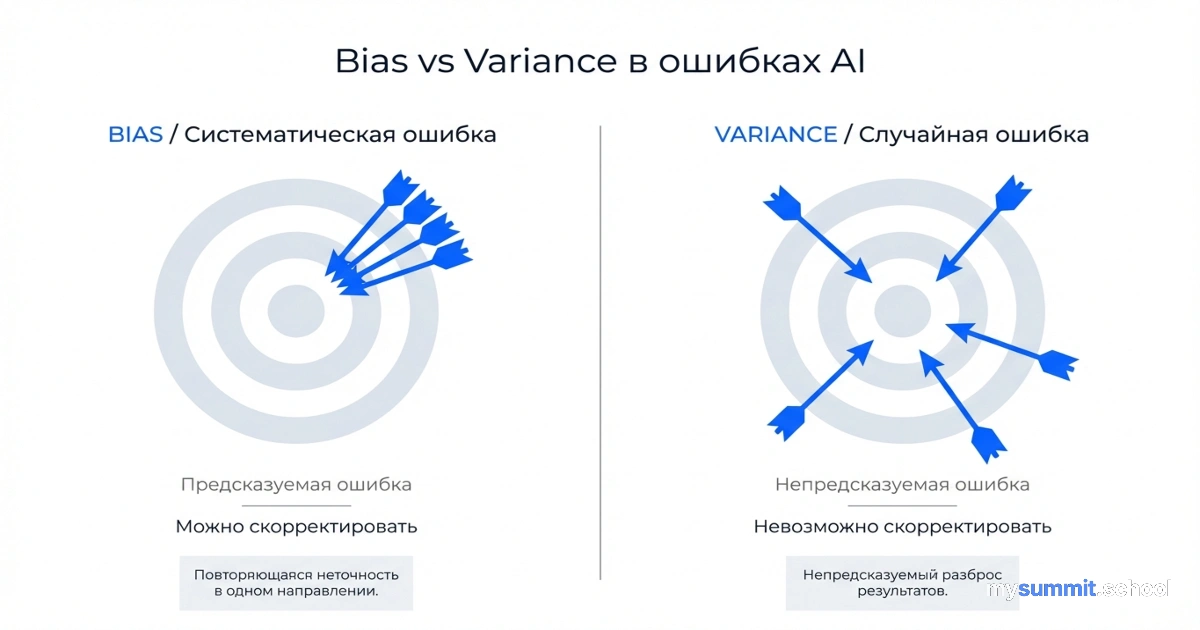

Почему провалилось:

ChatGPT – это языковая модель, а не поисковая система. Она генерирует правдоподобный текст на основе паттернов, но не проверяет факты. Если студент напишет “По данным McKinsey…”, модель не пойдет проверять, существует ли такое исследование.

Провал 2: Непонимание контекста курса

Задача: Оценить, насколько студент применил знания, полученные на курсе.

Что случилось:

Студентка написала эссе про “4P маркетинга” (Product, Price, Place, Promotion). Хороший текст, грамотный, структурированный. ChatGPT дал 8/10.

Проблема:

- Мы НЕ изучали классический 4P на курсе

- Проходили современные фреймворки: Jobs To Be Done, Growth Hacking, Product-Led Growth

- Студентка просто загуглила тему и переписала статью из интернета

ChatGPT не знал содержание нашего курса, поэтому оценил текст “в вакууме”.

Масштаб:

- 34 эссе из 120 (28%) были “не по теме курса”

- Студенты писали про то, что легко найти в Google, а не применяли знания с занятий

Решение, которое НЕ сработало:

Я попытался добавить в промпт:

Мы НЕ изучали: 4P, SWOT-анализ, классический маркетинг-микс

Мы изучали: JTBD, Growth Hacking, AARRR, Retention loops

ChatGPT все равно давал высокие оценки “классическим” эссе, если они были хорошо написаны.

Вывод: Модель не понимает “дух курса”, она оценивает текст как текст.

Провал 3: Отсутствие эмпатии в фидбеке

Что случилось:

Студент-новичок написал слабое эссе (реально на 4/10). ChatGPT дал честную оценку и фидбек:

“Эссе не соответствует требованиям. Отсутствует структура, примеры поверхностны, выводы не аргументированы. Рекомендую полностью переделать работу.”

Технически – все верно. Но студент написал нам на почту: “Я старался три дня, а робот за 2 минуты все растоптал. Может, этот курс не для меня.”

Масштаб проблемы:

- 12 студентов (10% от потока) отписались от курса после первой AI-проверки

- Средний чек студента: 25 000₽

- Финансовая потеря: 300 000₽

Чего не хватило:

Преподаватель Анна всегда находила что-то позитивное даже в слабой работе: “Хорошо, что попробовал применить фреймворк AARRR, давай доработаем”. Она знала, что студент – новичок, и ему нужна поддержка.

ChatGPT не знает эмоционального состояния студента, его background, количество попыток.

Попытка исправить:

Добавили в промпт:

Всегда начинайте с позитива, даже если работа слабая.

Укажите минимум 1-2 сильные стороны.

Фидбек должен мотивировать, а не демотивировать.

Результат: фидбек стал мягче, но “натянутым”. ChatGPT писал “Хорошо, что вы попытались”, когда явно не было ничего хорошего. Студенты чувствовали неискренность.

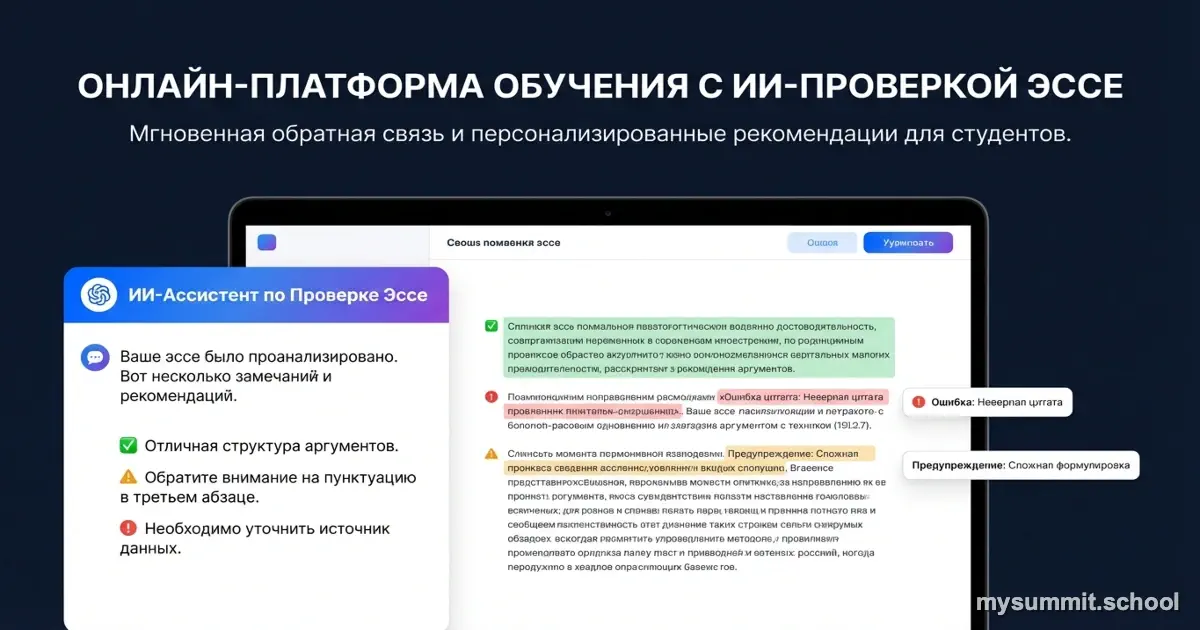

Что мы изменили: гибридная модель проверки

После месяца провалов мы перешли на гибридную схему:

Уровень 1: ChatGPT (автоматически)

Проверяет:

- Структура (есть введение, основная часть, заключение?)

- Грамматика и стиль

- Формальные требования (объем, форматирование)

Время: 2 минуты Результат: Студент сразу видит “техническую” оценку

Уровень 2: Преподаватель (вручную)

Проверяет:

- Фактическую точность (проверяет источники и цитаты)

- Соответствие содержанию курса

- Глубину понимания темы

- Пишет персонализированный фидбек с учетом контекста

Время: 8-10 минут (вместо 18 минут раньше) Результат: Итоговая оценка + развернутый комментарий

Реальные метрики гибридной модели (3 месяца работы)

Экономия времени:

- Было: 18 минут на эссе × 120 эссе = 36 часов/неделю

- Стало: (2 мин AI + 8 мин преподаватель) × 120 = 20 часов/неделю

- Экономия: 16 часов в неделю (44% времени)

Качество:

- Жалоб студентов: 2 в месяц (было 23 в первый месяц с полной автоматизацией)

- Удовлетворенность фидбеком: 87% (опрос 340 студентов)

- Отток после первой проверки: 1,2% (было 10%)

Стоимость:

- ChatGPT API: ~1 200₽/месяц

- Время преподавателя: 80 часов/месяц × 2 000₽/час = 160 000₽

- Было: 144 часа × 2 000₽ = 288 000₽

- Экономия: 128 000₽/месяц

Четыре урока внедрения AI в EdTech

Урок 1: AI отлично справляется с формой, но проваливается на смысле

ChatGPT – это идеальный корректор и редактор структуры. Но он не понимает:

- Правду ли говорит студент

- Применяет ли студент знания с курса

- Насколько глубоко понимание темы

Вывод: Используйте AI для проверки “формы” (структура, язык, форматирование), а человека – для проверки “смысла”.

Урок 2: Галлюцинации – это не баг, это фича языковых моделей

ChatGPT генерирует правдоподобный текст, но не имеет доступа к базе знаний. Если студент напишет “по данным исследования X”, модель не проверит, существует ли X.

Решение:

- Либо интегрируйте RAG (Retrieval-Augmented Generation) с базой проверенных источников

- Либо оставьте проверку фактов человеку

Мы выбрали второе – проще и дешевле для нашего масштаба.

Урок 3: Контекст курса не влезает в промпт

Я пытался впихнуть в system prompt:

- Список изученных тем

- Фреймворки, которые должны применять студенты

- Примеры из лекций

Промпт вырос до 3000 токенов. ChatGPT все равно оценивал “общее качество текста”, а не применение конкретных знаний.

Вывод: Для оценки применения знаний курса нужен человек, который этот курс вел.

Урок 4: Эмпатия – это человеческий навык

Хороший преподаватель знает:

- Это первая работа студента или десятая

- Студент старается, но не понимает тему, или ленится

- Нужна строгость или поддержка

ChatGPT не знает контекста и не умеет “читать между строк”. Он дает объективную оценку текста, но не чувствует человека за текстом.

Решение: Персональный фидбек всегда пишет преподаватель.

Где AI в образовании работает на 100%

Чтобы не создавать впечатление, что AI бесполезен в EdTech – вот задачи, где он реально закрывает 90-100% потребности:

1. Генерация тестовых вопросов

Задача: Создать 50 вопросов для квиза по пройденной теме.

Промпт:

На основе текста лекции создай 20 вопросов с вариантами ответа:

- 10 простых (проверка запоминания)

- 7 средних (понимание концепций)

- 3 сложных (применение на практике)

Результат:

- 50 вопросов за 5 минут (vs 3 часа вручную)

- Качество: 85% вопросов используем без правок

- Стоимость: ~15₽ за генерацию

2. Персонализация учебных материалов

Кейс: Студент не понял тему “Growth Loops”. Преподаватель объяснил, но не помогло.

Решение:

Объясни концепцию Growth Loops:

- На примере компании [Netflix] (студент указывает интересную ему отрасль)

- Используя аналогию с [маховиком]

- Уровень сложности: для новичка без технического background

ChatGPT создает персонализированное объяснение под студента.

Метрики:

- 78% студентов понимают тему после AI-объяснения

- Экономия времени преподавателя: 15 минут на каждую консультацию

3. Автоматизация FAQ

Задача: Студенты задают 200+ одинаковых вопросов в месяц (“Где найти запись?”, “Когда дедлайн?”, “Как получить сертификат?”).

Решение:

- ChatGPT-бот в Telegram с базой знаний из 150 FAQ

- Отвечает мгновенно на типовые вопросы

- Если не знает ответа – передает куратору

Метрики:

- 83% вопросов закрывает бот

- 17% передается людям

- Экономия: 40 часов куратора в месяц

Заключение: AI в образовании – это не замена преподавателя, а его инструмент

После 6 месяцев экспериментов с ChatGPT в онлайн-школе я понял: AI не заменит преподавателя, но может отлично дополнить его.

Что AI делает хорошо:

- Проверка формы (структура, язык, грамматика)

- Генерация контента (вопросы, объяснения, примеры)

- Автоматизация FAQ и рутинных задач

- Персонализация материалов под студента

Что AI НЕ умеет (пока):

- Проверка фактов и источников

- Оценка глубины понимания темы

- Учет контекста курса и личности студента

- Эмпатия и мотивационный фидбек

Три правила успешного внедрения:

Начинайте с низких рисков

- Сначала – генерация вопросов и FAQ-бот

- Потом – проверка структуры эссе

- В последнюю очередь – оценка содержания (только с проверкой человеком)

Гибридная модель обязательна

- AI проверяет форму и дает быстрый фидбек

- Человек проверяет смысл и пишет персональный комментарий

- Никогда не давайте AI финальное слово в оценке

Считайте реальную экономику

- Не только стоимость API ($1200/мес в нашем случае)

- Но и время на интеграцию (40 часов разработки)

- И стоимость ошибок (300 000₽ потерянных студентов в первый месяц)

- ROI проявляется через 3-4 месяца

Важное уточнение по моделям (2025 год):

Мы используем gpt-4o-mini для всех задач проверки – его более чем достаточно. Пробовали gpt-4o – разница в качестве незаметна для наших задач, а стоит в 17 раз дороже.

Новые модели o1-mini тестировали для проверки сложных кейсов (когда студент должен провести анализ и предложить решение). Работают чуть лучше, но стоят дороже. Пока не перешли – экономика не сходится.

От провалов к работающим решениям: AI в обучении

Открытый модуль курса: как детектировать галлюцинации ChatGPT при проверке работ, настраивать промпты для образовательного контента, строить гибридные модели AI + человек. С примерами кода и кейсами.

Кстати, похожую проблему с галлюцинациями и проверкой фактов мы разбирали в статье про корпоративное внедрение ChatGPT – там модель тоже “додумывала” несуществующие данные о заказах клиентов.

Источники и дополнительные материалы

- HolonIQ Research: AI in Education 2024-2025 – исследование о внедрении AI в EdTech с данными по успешности пилотов

- OpenAI API Documentation – официальная документация по работе с ChatGPT API

- OpenAI Pricing (2025) – актуальные цены на модели gpt-4o, gpt-4o-mini, o1

- Python OpenAI SDK на GitHub – примеры интеграции с новым синтаксисом (v1.0+)

Есть опыт внедрения AI в образовании? Напишите нам на welcome@mysummit.school – разберем ваш кейс!