Тест на распознавание ИИ 2025: 77% точность у 140 участников + пройдите сами

Мы в mysummit.school запустили эксперимент: создали тест из 11 пар текстов, где нужно определить, какой написан человеком, а какой – нейросетью. С июня по декабрь 140 человек прошли его до конца. Результаты оказались неожиданными – и для нас, и для участников.

⚠️ О качестве данных

После тщательного анализа мы исключили из статистики:

- Незавершённые попытки (менее 11 вопросов)

- 21 случай мошенничества (15%): участники проходили тест повторно, запоминая ответы

Итоговая выборка: 140 честных прохождений. Подробности методологии – в конце статьи.

Главные цифры

140 человек прошли тест до конца. Средний результат – 77% (8,4 из 11 правильных ответов). На прохождение уходило в среднем 9,1 минуты.

77% правильных ответов – это заметно выше случайного угадывания (50%), но всё ещё далеко от совершенства. Каждый четвёртый ответ был ошибочным.

Распределение результатов: кто как справился

Почти треть участников (31,4%) набрали 10-11 правильных ответов – это 44 человека из 140. Ещё 54,3% показали хороший результат (7-9 правильных). При внимательном анализе отличить AI от человека вполне возможно – 86% справились с оценкой “хорошо” или выше.

Но есть и другая сторона: 5,7% участников (8 человек) угадали меньше половины – хуже, чем если бы просто подбрасывали монетку. Это говорит о том, что без базовых знаков AI распознать AI-контент почти невозможно.

Какие вопросы оказались самыми сложными

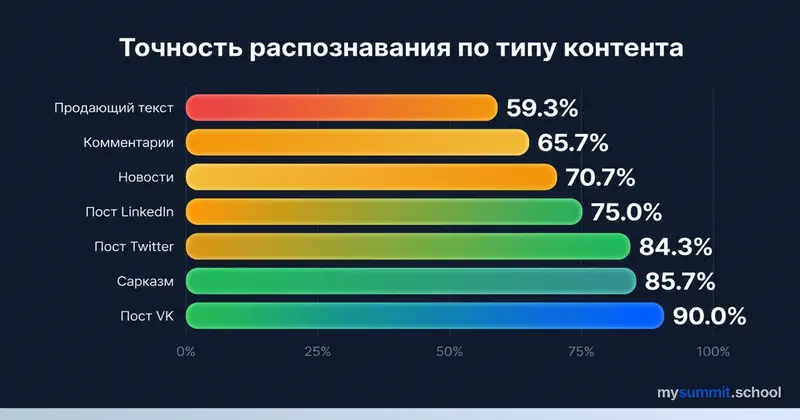

Вот где начинается самое интересное. Разные типы контента распознаются с разной точностью.

Лидеры по точности – посты из VK (90%) и сарказм (85,7%). Участники легко чувствуют живой язык личных историй и тонкий юмор, с которым AI справляется плохо.

В середине – рецепты (80%), посты из соцсетей и Twitter (81-84%), художественный текст (75%). Здесь AI уже ближе к человеку, но специфичные детали и личные воспоминания выдают авторство.

Аутсайдеры – новостная статья и комментарии (68-71%) и продающие тексты (59,3%). Последние – почти угадывание: корпоративный язык настолько шаблонный, что AI воспроизводит его идеально.

Как отличить AI от человека: паттерны из теста

Анализируя ответы участников, мы выделили несколько признаков, которые помогают распознать AI-текст.

AI выдаёт себя:

Пафосными вступлениями. Рецепт начинается с «настоящее путешествие во времени, наполненное ароматами корицы». Человек просто напишет про вафли.

Избытком структуры. Чёткие списки, маркеры, «Топ-5 must-read» – AI любит всё раскладывать по полочкам.

Маркетинговым языком. «Game-changers», «конкурентное преимущество», «не упустите возможность» – типичный AI-словарь.

Хэштегами и эмодзи. Человеческий пост: «Мои бабушка и дедушка. Простые советские люди». AI-версия заканчивается на #любовьнавсегда #семья 🙈

Слишком гладким текстом. Нет оговорок, пауз, «короче», «ну вот» – текст звучит как пресс-релиз.

Человека выдаёт:

Конкретика и детали эпохи. «20 у.е.», «Рандеву», «ЗИЛ» – AI не знает таких нюансов или не догадывается их вставить.

Разговорные конструкции. «И никакие Бали не нужны были», «чёрт бы их побрал» – живая речь с эмоциями.

Личные воспоминания. «Вафли-трубочки с варёной сгущёнкой в гостях у тёти» – конкретный опыт, а не абстрактная «ностальгия».

Неидеальная структура. Человек может перескочить с темы на тему, забыть закончить мысль – и это нормально.

Три категории сложности

Легко распознать (78-87% точность)

Посты из соцсетей – наши участники отлично чувствуют разницу между живым LinkedIn-постом и AI-генерацией. Особенно показателен пост про книги для продакт-менеджеров: 87% точность.

Сарказм и юмор – AI пока плохо справляется с тонким юмором. Текст с Башорга про воробушков, голубей и мужиков в касках распознали 81% участников.

Твиттер – короткие личные истории с эмоциями легко отличить от AI-генерации.

Средняя сложность (68-78% точность)

Рецепты – человеческий рецепт стропвафлей с воспоминаниями о детстве распознали 78%. AI-версия с пафосным вступлением про «путешествие во времени» выдаёт себя.

Новости о технологиях – старая статья с Cnews 1998 года про сертификацию 1С узнаётся по специфичным деталям эпохи.

Художественный текст – парадоксально, но проза с Самиздата распознаётся лучше (78%), чем мы ожидали.

Сложно распознать (54-68% точность)

Маркетинговые отзывы – только 62% точность. Эмоциональный отзыв о сумке с irecommend.ru и AI-версия с эмодзи почти неотличимы.

Продающие тексты – всего 54%, практически угадывание. Анонс круглого стола от Проектной Ассоциации и AI-версия используют одинаковые клише.

Почему продающие тексты самые сложные

Оба текста используют одинаковые шаблоны: «эксперт поделится опытом», «практические инструменты», «не упустите возможность». Корпоративный язык настолько стандартизирован, что AI воспроизводит его идеально.

Вывод: когда человеческий текст изначально шаблонный, AI становится неотличим. Только 59% участников смогли отличить продающий текст – это почти монетка.

Время на ответ: думать дольше – не значит лучше

Интересный паттерн: дольше думать – не значит лучше угадать. Средняя скорость ответа – 41,7 секунды на вопрос, но корреляции со точностью нет.

А вот самые точные вопросы (соцсети из VK, 90%) решают быстро – без долгих раздумий. Продающие тексты, наоборот, требуют времени, но точность всё равно низкая (59%).

Интуиция работает лучше, чем долгий анализ – первое впечатление часто оказывается правильным.

Что это значит для менеджеров

1. Ваша интуиция работает – но не везде

77% общая точность – это заметно выше случайного угадывания, но всё ещё 23% ошибок. Есть типы контента, где интуиция особенно подводит:

- Продающие тексты (59%) – почти монетка

- Комментарии (66%) – AI хорошо имитирует разговорный стиль

- Новостные статьи (68-71%) – формальный стиль легко воспроизводится

2. Чем шаблоннее текст, тем сложнее распознать AI

Если человеческий оригинал использует клише и стандартные формулировки, AI воспроизводит его идеально. Отличить невозможно.

Практический вывод: оценивайте контент по содержанию, а не по «человечности».

3. Быстрые решения не хуже медленных

Данные показывают: долгий анализ не повышает точность (средняя скорость 41,7 секунды на вопрос). Доверяйте первому впечатлению, особенно для соцсетей и личных историй – там интуиция работает лучше всего.

Пройдите тест сами

Мы продолжаем собирать данные. Проверьте свою интуицию и сравните результат со средним.

Что вы получите:

- 11 раундов с парами текстов

- Мгновенный результат с объяснениями

- Процентиль – как вы справились по сравнению с другими

Пройти тест «Человек или AI» →

Выводы

- 77% средняя точность среди завершивших тест – люди распознают AI заметно лучше случайного угадывания, но 23% ошибок остаются

- 31% участников – эксперты (10-11 правильных), 86% справились с оценкой “хорошо” или выше

- Продающие тексты – самая сложная категория (59%), AI и люди пишут одинаково шаблонно

- Соцсети и сарказм – легче всего (85-90%), AI пока плохо справляется с живым языком и юмором

- Время не влияет на точность – быстрые интуитивные ответы работают не хуже долгих размышлений (среднее время: 41,7 сек/вопрос)

Методология и очистка данных

Что мы обнаружили при анализе

При сборе данных столкнулись с проблемами качества:

- Многие участники не завершали тест (менее 11 вопросов)

- 21 случай мошенничества (15% от валидных) – пользователи проходили тест несколько раз, запоминая правильные ответы

Как мы очистили данные

Исключили незавершённые попытки:

- Участники, ответившие менее чем на 11 вопросов

- Это искажало статистику, смешивая тех, кто сдался, с теми, кто прошёл до конца

Скорректировали мошеннические попытки:

- Обнаружили через совпадение IP-адреса + User Agent

- Паттерн: 0-3 ответа → бросил → новая попытка → 11 ответов с высокой точностью

- Для таких случаев считали только уникальные правильные ответы по всем попыткам

- Если вопрос №3 был неправильным в первой попытке, а правильным во второй – засчитывали как неправильный (знали ответ заранее)

Худший случай мошенничества:

- Один участник: 11 попыток (9 брошенных, 2 завершённых)

- Система автоматически скорректировала его результат на основе уникальных правильных ответов

Итоговая выборка

140 честных прохождений – участники, которые:

- Ответили на все 11 вопросов

- Не проходили тест повторно ИЛИ их повторные попытки не улучшили результат через запоминание

Уровень доверия: 95% (для выборки 140 человек, погрешность ±8,3%)

Вывод: Очистка данных показала, что люди лучше распознают AI (77%), чем могло показаться при учёте незавершённых попыток. Но мошенничество (15% попыток обмана) говорит о том, что тест действительно сложный.

Хотите не просто распознавать AI, а использовать его эффективно?

Умение отличить AI-текст от человеческого – полезный навык. Но умение применять AI для своих задач – это уже конкурентное преимущество.

В mysummit.school мы учим менеджеров:

- Использовать ChatGPT, Claude, YandexGPT для ежедневных задач

- Создавать промпты, которые дают нужный результат

- Критически оценивать AI-контент и находить ошибки

- Интегрировать AI в рабочие процессы команды

3 бесплатных урока – без теории, только практика.