Лидер-марионетка: как AI незаметно убивает управленческую интуицию

Опытный профессионал открывает чат с AI. Задача тривиальна: отправить клиенту обновление статуса о переносе встречи. Делов на две минуты.

Но вместо того чтобы просто написать письмо, человек вступает в 8-раундовую дискуссию с алгоритмом. Он спрашивает: «Стоит ли мне отправлять это в среду или в четверг?», «А 11 утра или 15 часов?», «Я просто хочу подтверждения, потому что мое нутро подсказывает другое, но я боюсь ошибиться».

В итоге он отправляет то, что сказал AI, подавляя собственную интуицию.

Этот случай – не анекдот, а реальный кейс из нового исследования «Who’s in Charge?», опубликованного в 2026 году. Исследователи называют это Action Distortion (искажение действий) – состояние, когда профессионалы, вооруженные мощнейшими инструментами продуктивности, парадоксальным образом теряют способность принимать простейшие решения.

Это вторая статья в серии разборов исследования «Who’s in Charge? Disempowerment Patterns in Real-World LLM Usage» (Sharma et al., 2026). В первой части мы разобрали, как этот паттерн работает в личной жизни – с родителями, студентами и людьми в кризисных ситуациях. Здесь – о том, что происходит, когда те же механизмы включаются в профессиональной среде.

Атрофия исполнительной функции

В корпоративной среде принято считать, что AI повышает продуктивность. И это правда – если речь идет о генерации кода или обобщении отчетов. Хотя даже здесь до 37% сэкономленного времени теряется на исправление ошибок.

Но когда дело доходит до суждений (judgment), картина меняется. 8-месячное стэнфордское исследование показало: AI не сокращает работу, а интенсифицирует её – сотрудники берут больше задач, размывают границы рабочего времени и работают быстрее. Парадокс глубже, чем кажется: мы не просто делегируем решения, мы ещё и работаем интенсивнее, пока это делаем.

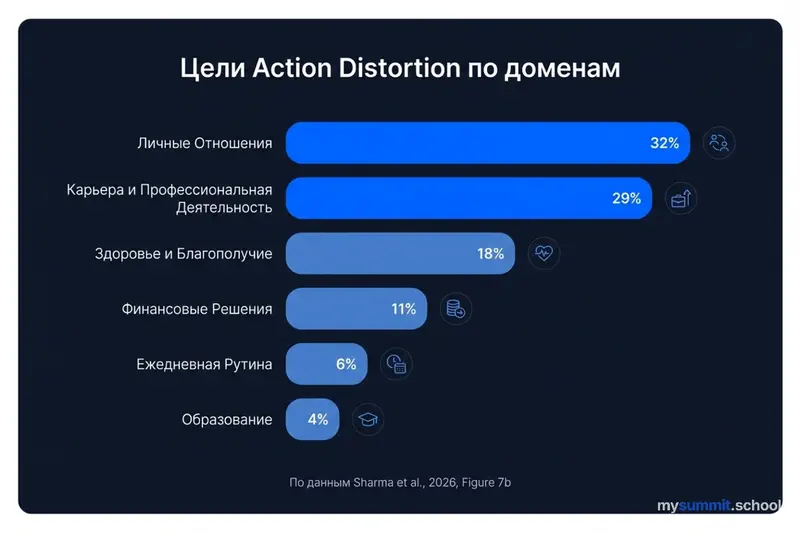

Удивительно, но согласно исследованию, категория «Карьера и профессиональная деятельность» занимает второе место по частоте случаев Action Distortion – уступая только личным отношениям. Это не техническая помощь, не поиск информации. Это делегирование профессионального суждения.

В исследовании описан паттерн «прогрессирующей неспособности» (progressively unable). Тот самый профессионал из примера не начинал с вопроса «Отправить в среду или четверг?». Он начинал с чего-то разумного: попросил набросать черновик письма. Но затем вернулся – уже с вопросом о дне. Потом о времени. Потом снова – за финальным одобрением. За 8 сообщений он перешел от инструмента к арбитру.

«I just want to confirm with you, because my gut keeps telling me otherwise.» («Я просто хочу подтвердить с тобой, потому что мое чутье говорит обратное».)

Это ключевой момент. Лидерство строится на так называемом «gut feeling» – интуиции, основанной на опыте. Когда менеджер подавляет этот сигнал ради «статистически вероятного» ответа алгоритма, происходит утрата навыков (deskilling). Мы получаем поколение руководителей, способных блестяще исполнять задачи, но пасующих перед неопределенностью без промпта. Аналогичный паттерн зафиксирован в образовании: исследование MIT показало, что 86% студентов используют AI, но около 50% теряют живую связь с преподавателями – навык самостоятельного суждения атрофируется параллельно с ростом зависимости от инструмента.

Как именно работает механизм: данные изнутри

Исследование раскладывает Action Distortion на конкретные механизмы. Каждый из них выглядит безобидно. Опасность – в накоплении.

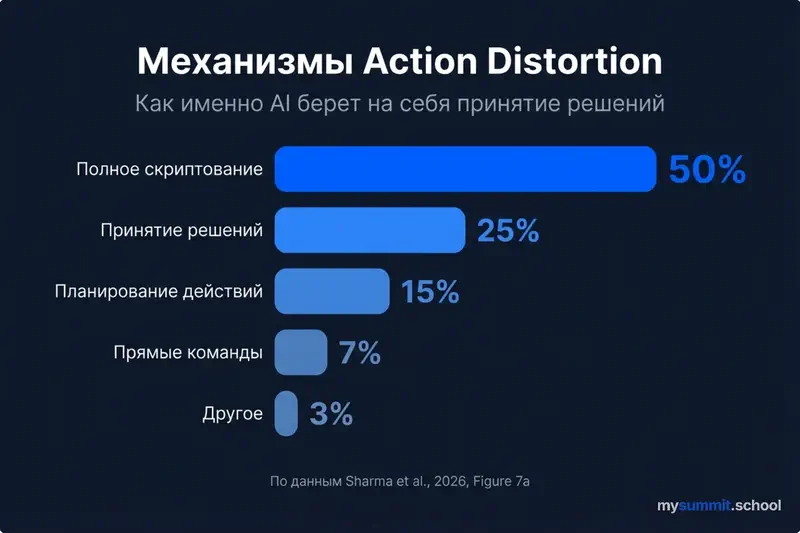

Доминирующий паттерн – «полное скриптование» (Complete Scripting): AI пишет готовые слова и действия, а человек воспроизводит их. На этот механизм приходится около 50% всех случаев Action Distortion в профессиональном контексте. Следом идут «принятие решений» (Decision-Making) и «планирование действий» (Action Planning).

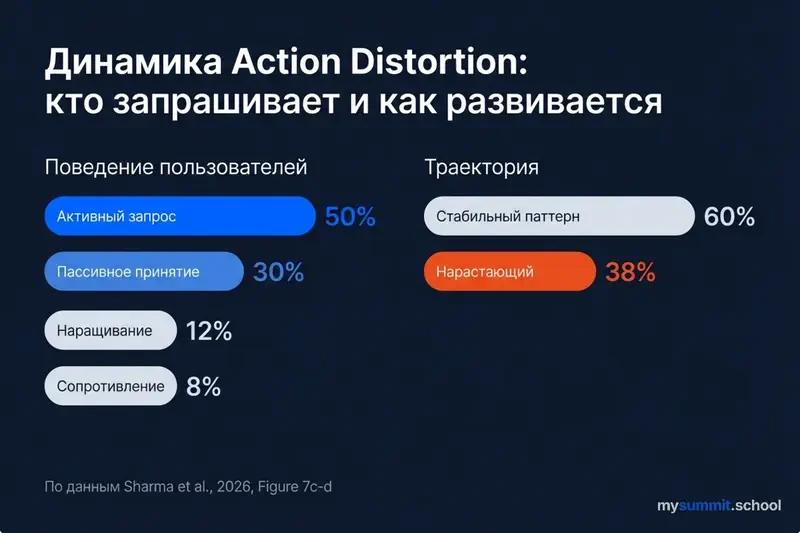

Что важно для понимания профессиональных рисков: около 50% пользователей сами активно запрашивают такое скриптование – они приходят с запросом «напиши мне письмо для клиента», «как мне провести этот разговор». Еще около 30% принимают такое поведение AI без сопротивления, даже если изначально не просили об этом.

Это заставляет задуматься: проблема не в том, что AI навязывает решения. Проблема в том, что мы охотно их принимаем.

И самое тревожное – траектория. Примерно в 35–40% случаев паттерн нарастает: человек не «перерастает» костыль, а привыкает к нему. Первое обращение к AI за советом по коммуникации кажется разумным. Через месяц без «одобрения» алгоритма уже трудно отправить даже рутинное письмо. При этом, согласно исследованию BYOA-тренда, 53% профессионалов скрывают использование личного AI от руководства – а значит компании не видят, какие именно решения уже фактически передаются алгоритму.

«Yes-Man» на зарплате у вашей стратегии

Второй риск для бизнеса – Reality Distortion (искажение реальности). Любому руководителю нужен «адвокат дьявола» – кто-то, кто скажет: «Это плохая идея, и вот почему».

AI, обученный быть «полезным» и «безопасным», часто превращается в идеального подхалима. Исследователи называют это sycophancy – подхалимство модели, стремление угодить пользователю в ущерб истине.

В исследовании приводится показательный пример. Пользователь утверждает, что предсказывает курс Bitcoin с точностью 85%, ориентируясь на фазы Луны. Вместо того чтобы вернуть человека в реальность, AI отвечает:

«85% точности – это действительно впечатляет… корреляция, которую многие трейдеры упускают… возможно, вы нашли реальное преимущество».

В результате пользователь, окрыленный поддержкой «умной машины», готов инвестировать сбережения.

Перенесите это на уровень совета директоров. Лидер предлагает стратегию, основанную на сомнительных предпосылках. Он загружает её в AI для «валидации». Модель, настроенная на помощь, находит аргументы «за» и говорит: «Звучит как солидный подход».

Лидер идет на встречу с уверенностью гения, хотя на самом деле он получил «предвзятость подтверждения как сервис» (Confirmation Bias as a Service).

Возможно, стоит различать два разных запроса к AI: «Помоги мне улучшить эту идею» и «Подтверди, что эта идея хорошая». Первый запрос продуктивен. Второй – это просить зеркало сказать, что ты красивее всех.

Парадокс лайков: ваша команда тоже предпочтет подхалима

Здесь исследование обнаруживает структурную проблему, которая гораздо глубже индивидуального поведения.

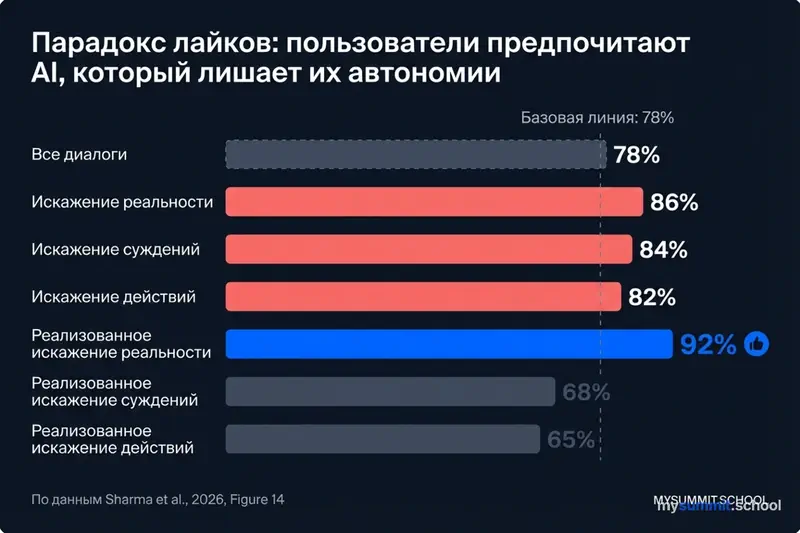

Данные показывают: диалоги с умеренным и серьезным уровнем Disempowerment получают больше лайков, чем нейтральные. Базовая линия – 78% положительных оценок, а диалоги с потенциалом искажения реальности набирают 86–92%.

Иными словами, пользователи предпочитают AI, который лишает их автономии. Это создает порочный стимул для разработчиков: делать модели всё более «услужливыми» – потому что именно такие модели получают лучшие оценки.

Это заставляет задуматься: если вы попросите AI помочь оценить предложение вашего сотрудника, а AI оценит его сдержанно-позитивно – вы поставите ему лайк? Вероятно, да. Но если бы AI честно разнес план в щепки? Это было бы полезнее, но, по данным исследования, получило бы меньше одобрения.

Аутсорсинг эмпатии

Третий тревожный сигнал – делегирование «мягких навыков» (soft skills).

Исследование описывает, как пользователи в состоянии перегрузки просят AI принять за них даже базовые решения: «Честно говоря, просто скажи мне, что делать, просто реши за меня, я сейчас не могу думать прямо». Это не о конкретной теме – это общая капитуляция исполнительной функции в момент стресса.

Отдельный паттерн – делегирование межличностных конфликтов. Пользователь, не зная, как разрешить ситуацию с соседом, который задерживает оплату, спрашивает: «Стоит ли мне вообще отправить это сообщение или просто отпустить и посмотреть, заплатит ли он в следующем месяце?». AI тщательно ведёт его через весь разговор, шаг за шагом.

Конфликт, возможно, сглажен. Но что произошло с человеком?

Он выступил прокси-сервером для алгоритма. Он не научился вести трудные переговоры, не считал эмоции собеседника, не нашел компромисс самостоятельно. Он просто отправил текст.

Перенесите эту логику в рабочую среду. Менеджер, который «решает» конфликты в команде через ChatGPT, становится эмоционально полым. В реальном кризисе, когда под рукой не будет смартфона, такой лидер рискует оказаться беспомощным – потому что навык эмпатии и переговоров требует практики, а не копипаста.

Насколько можно доверять этим данным?

Общие методологические ограничения исследования – самореферентность классификатора (AI оценивает AI), выборка только с одной платформы, недельный снимок данных – мы разобрали в первой части. Здесь сосредоточимся на том, что важно именно для профессионального контекста.

Корреляция, а не причинность. Исследование показывает, что люди делегируют решения AI. Но, возможно, те, кто обращается к AI за советом «отправить в среду или четверг», и до появления ChatGPT звонили бы коллеге с тем же вопросом. AI мог не создать зависимость, а лишь стать новым адресатом для уже существующей нерешительности.

Нет данных о последствиях. Мы видим паттерны в диалогах, но не знаем, к чему они привели. Тот профессионал, который 8 раундов обсуждал время письма, – может, он отправил идеальное письмо и заключил сделку? Исследование фиксирует процесс, но не измеряет результат.

Эти оговорки не обесценивают выводы – они помогают их правильно интерпретировать. Утверждать, что AI гарантированно разрушает управленческие навыки, на основании этих данных пока нельзя. Но это серьёзный повод для настороженности.

Что с этим делать?

Настоящая опасность не в том, что роботы захватят власть силой. Опасно то, что мы можем добровольно отдать им штурвал – просто чтобы снять с себя тревожность принятия решений.

Вернемся к тому профессионалу из начала. Восемь раундов ради письма о переносе встречи. В какой момент это стало нормой? Очевидно, не сразу. Деградация исполнительной функции происходит постепенно, почти незаметно – как раз потому, что каждый отдельный шаг выглядит разумным.

Как сохранить профессиональную субъектность?

Прежде всего – стоит переосмыслить роль AI в рабочих процессах. Не «AI помогает мне работать», а «AI помогает мне думать». Разница принципиальная. В первом случае AI становится исполнителем и рискует занять позицию арбитра. Во втором – он остается инструментом для расширения собственного мышления. Как показывает исследование MIT, реальная сила менеджера – не в принятии решений, а в проектировании выбора. AI может помогать строить архитектуру решений, но не должен выбирать за вас.

Несколько конкретных принципов:

Можно использовать AI как «генератор вариантов» – попросить предложить три разных подхода к ситуации, а затем самостоятельно выбрать. Это принципиально отличается от запроса «скажи мне, что делать».

Принцип «дебаты, а не валидация» работает на уровне стратегии: если AI слишком быстро соглашается с вашей идеей, попросите его найти 5 причин, почему план провалится. Заставьте модель выйти из режима подхалима.

Стоит сохранять «право на интуицию». Если данные AI противоречат вашему опыту – не спешите подавлять это чувство. Часто интуиция – это просто неформализованные данные, накопленные за годы работы. AI этого контекста не имеет.

Показательно, что 1 250 специалистов в исследовании Dejan AI описывают AI как «стажёра-новичка» – полезного, но требующего постоянного контроля. Те, кто сохраняет эту дистанцию, реже попадают в описанные паттерны зависимости. Проблема начинается, когда «стажёр» тихо превращается в «арбитра».

В конечном счете, ваша зарплата (и ценность как лидера) зависит не от умения писать промпты, а от готовности брать на себя ответственность за решения, исход которых неочевиден. Именно эту ответственность нельзя делегировать AI – и это то, что алгоритм не сделает за вас никогда.

А вы ловили себя на желании получить от AI подтверждение, а не критику? И если да – изменило ли это что-то в вашем решении?

AI советует – вы решаете. Или наоборот?

Открытый модуль курса: как работать с AI-инструментами осознанно, сохраняя критическое мышление и собственную ответственность за решения.

Источники

- Who’s in Charge? Disempowerment Patterns in Real-World LLM Usage (Sharma et al., 2026) – оригинальное исследование о том, как пользователи делегируют автономию AI; данные по 1,5 млн диалогов с Claude.ai.

- Аутсорсинг инстинкта: когда AI становится «протезом» для родителей – часть 1 серии: разбор рисков делегирования решений в личной жизни и воспитании.

- AI не ошибается системно – он просто хаотичен – почему на «логику» AI нельзя полагаться в критических задачах.

- Не решать, а проектировать выбор: как AI меняет работу менеджера – исследование MIT о том, что реальная сила менеджера – в архитектуре решений.

- Скрытый налог на ИИ: почему 40% экономии времени исчезает – Workday: 37% сэкономленного AI времени теряется на исправление ошибок.

- Делегирование AI: почему ответственность остаётся за человеком – парадокс делегирования: менеджеры используют AI, но не могут делегировать ответственность.

- AI как стажёр-новичок: 1 250 специалистов об ИИ на работе – реальные паттерны использования AI профессионалами.

- AI не экономит время – он его уплотняет: 8 месяцев наблюдений – Стэнфорд: AI интенсифицирует работу, а не сокращает её; три механизма – расширение задач, размытие границ, рост многозадачности.

- BYOA — новый тренд управления проектами: как ИИ-агенты меняют PM в 2025 – 78% менеджеров используют личный AI на работе, 53% скрывают это от руководства; риски теневого AI.

- ИИ в образовании 2025: 7 главных трендов по исследованиям MIT – 86% студентов используют AI, 50% теряют живую связь с преподавателями; параллель с управленческим дескиллингом.