BYOA — новый тренд управления проектами: как ИИ-агенты меняют PM в 2025

Пока корпорации тратят месяцы на согласование внедрения Microsoft Copilot или разработку собственных LLM, проектные менеджеры (ПМ) уже живут в будущем. Они не ждут. Они открывают ноутбук, логинятся в личный аккаунт ChatGPT Plus или Claude Pro и решают задачи за 15 минут вместо четырех часов.

Этот феномен получил название BYOA (Bring Your Own Agent) – по аналогии с BYOD (Bring Your Own Device). Это ситуация, когда личные инструменты сотрудника превосходят корпоративные по мощности, гибкости и скорости.

Согласно исследованию Microsoft Work Trend Index (2025), 78% пользователей ИИ приносят свои собственные инструменты на работу. Причина номер один – «это помогает мне справляться с темпом работы». Более того, 53% людей боятся признаться в этом начальству. Звучит знакомо?

Это подтверждает и наш недавний анализ исследования Dejan.AI: профессионалы используют AI как младшего помощника, не сообщая об этом руководству. Данные Gallup показывают, что 45% американцев используют ИИ регулярно, но большая часть этого использования – личные инструменты, не корпоративные.

Главное: BYOA даёт невероятное конкурентное преимущество здесь и сейчас, но превращает менеджера в ходячую уязвимость для информационной безопасности компании. Разбираем, почему ПМы идут на риск, какие проблемы решает BYOA и как работать с AI безопасно.

Почему ПМы выбирают BYOA: три фундаментальные проблемы

Чтобы ИИ был полезен менеджеру, он должен понимать проект так же глубоко, как сам менеджер. Корпоративные боты часто «стерильны»: они знают общие правила, но не знают специфики. Личные агенты решают это через гипер-персонализацию.

Проблема №1: Контекст – «Кто все эти люди?»

Корпоративный бот не понимает, что «заказчик А» всегда требует отчёты по пятницам, а в «проекте Х» высокий риск из-за легаси-кода. Два года назад мы исследовали, насколько GPT полезен для проектных менеджеров, и главная проблема была именно в этом – отсутствие контекста. Модели не могли запомнить специфику проекта, и каждый промпт приходилось начинать с нуля.

В 2025 году ситуация кардинально изменилась: появились Custom GPT, огромные контекстные окна (200 000 токенов у Claude, 1 млн у Gemini), и возможность загружать файлы напрямую. ПМ создаёт кастомного агента, в который вручную загружает Устав проекта, глоссарий, историю переписки и «культурный код» команды.

Агент становится виртуальным членом команды, который понимает с полуслова. Вместо длинного промпта ПМ пишет: «Напиши письмо стейкхолдерам в нашем обычном тоне о задержке релиза», и агент делает это идеально, потому что у него есть контекст.

Пример из практики:

Менеджер проекта в IT-компании создал Custom GPT для проекта миграции корпоративной CRM. Вот как изменилась его работа:

До BYOA (классический подход):

- Промпт на 500 слов: «Ты – эксперт по проектному менеджменту. Мы делаем проект миграции для клиента из финтеха. У нас 3 команды: фронтенд (5 человек, React), бэкенд (7 человек, Java Spring), DevOps (2 человека). Клиент очень требовательный, всегда хочет детальные отчёты по пятницам. Сейчас у нас задержка на 2 недели из-за проблем с легаси-кодом…»

- Результат: общие советы, которые нужно адаптировать вручную

- Время на подготовку статус-отчёта: 1,5 часа

После BYOA (Custom GPT с контекстом):

- Промпт: «Составь статус по обычному шаблону про задержку интеграции платёжного модуля»

- Агент знает: структуру команд, стиль общения с клиентом, формат отчётов, терминологию проекта

- Результат: готовый отчёт, который требует минимальной правки

- Время на подготовку: 10 минут

Разница: экономия 80 минут на каждом статус-отчёте (2 раза в неделю = 10 часов в месяц).

Проблема №2: Доступ – «Стены безопасности»

Чтобы автоматизировать отчётность в корпоративной среде, нужно ждать интеграции Jira с SAP полгода. IT-отдел, безопасность, согласования – бесконечный цикл.

ПМ находит выход: выступает в роли «человеческого middleware». Выгружает CSV из Jira, анонимизирует данные (заменяет названия клиентов на «Клиент А», суммы делит на 1000) и скармливает их в Code Interpreter – аналитический модуль ChatGPT. Аналитика «здесь и сейчас»: графики Burn-down, прогноз бюджета и выявление узких мест доступны мгновенно, без участия IT-отдела.

Но есть нюанс: даже анонимизированные данные могут содержать паттерны, по которым можно восстановить связь с реальным проектом. Об этом – в разделе про безопасность ниже.

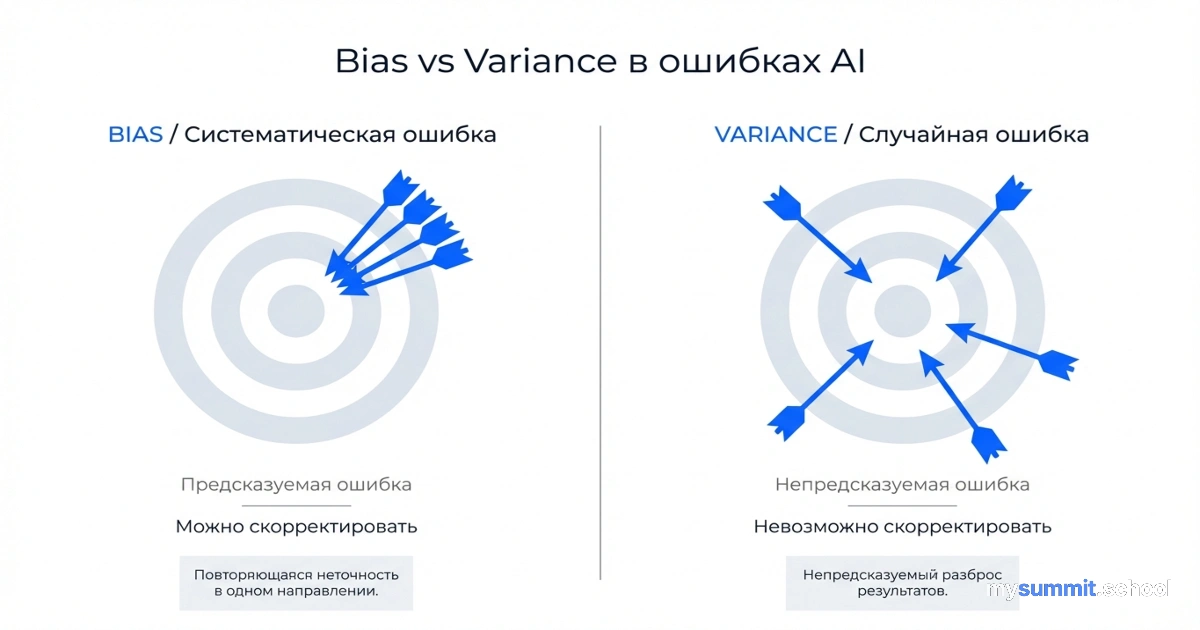

Проблема №3: Actionable Knowledge – «Галлюцинации против решений»

Корпоративные модели часто урезаны (quantized) для экономии или скованы жёсткими правилами безопасности (Guardrails), из-за чего дают сухие, бесполезные ответы. ПМ обходит это, используя флагманские модели – GPT-4o, Claude 3.5 Sonnet – способные к сложному рассуждению (Chain-of-Thought).

Вместо общих советов ПМ получает Triable Knowledge – проверяемые гипотезы. «Судя по логам, проблема не в скорости разработки, а в долгом Code Review. Вот 3 варианта, как это исправить…».

Сравните:

Корпоративный AI: «Рекомендую оптимизировать процессы и провести встречу с командой»

Ваш агент: «Анализируя velocity за 3 спринта, узкое место – code review (среднее время 3,2 дня). Попробуй: 1) Ввести лимит времени на ревью (24 часа), 2) Ротацию reviewer-ов по pull request, 3) Внедрить пре-комит чек-лист»

Обратная сторона медали: Проблема «Айсберга»

Кажется, что BYOA – идеальное решение. Но исследование компании Sierra (разработчики AI-платформ) показывает, почему это тупиковый путь для масштабирования.

Создание личного агента – это лишь верхушка айсберга. ПМ видит только то, что на поверхности: быстрый ответ на вопрос. Но под водой скрываются огромные риски, которые в модели BYOA игнорируются:

Что скрывается под водой:

Отсутствие «Guardrails» (Ограничителей): Личный агент может посоветовать решение, противоречащее политике компании или закону. Например, предложить способ обхода процедуры закупок «для экономии времени».

Потеря знаний: Если ПМ уволится, его идеально настроенный Custom GPT уйдёт вместе с ним. Компания теряет накопленный контекст, а новому менеджеру придётся начинать с нуля.

Утечка данных: Это самый критичный риск. Данные, загруженные в публичные чаты, могут использоваться для дообучения моделей. Даже если вы используете платную версию с заявлениями о Zero Data Retention, нет 100% гарантии.

Отсутствие аудита: Если AI дал рекомендацию, которая привела к проблеме, компания не может восстановить цепочку принятия решений. Корпоративные системы логируют все взаимодействия.

Нарушение комплаенса: 152-ФЗ о персональных данных в России, GDPR в Европе, HIPAA в здравоохранении – все эти требования нарушаются при использовании публичных AI-сервисов для обработки чувствительных данных.

Учитесь использовать AI безопасно – 3 урока бесплатно

Без платёжных данных • Доступ сразу после регистрации

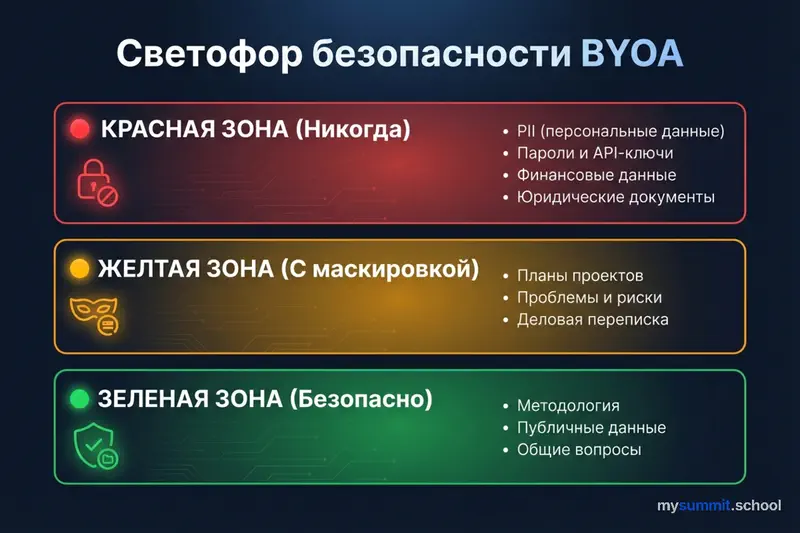

Светофор безопасности: Чек-лист цифровой гигиены

Если вы практикуете BYOA, вы становитесь «Директором по безопасности» своего маленького карманного ИТ-отдела. Ошибка здесь может стоить карьеры.

Используйте этот светофорный протокол для любых данных, передаваемых в ИИ.

🔴 КРАСНАЯ ЗОНА (Никогда не загружать)

Данные, которые могут идентифицировать компанию, сотрудников или привести к прямым финансовым потерям.

- PII (Персональные данные): ФИО, личные телефоны, email-адреса

- Secrets (Секреты доступа): Пароли, API-ключи, токены, ссылки на закрытые сервера

- Финансы: Точные бюджеты с названиями контрагентов, номера счетов, зарплатные ведомости

- Юридическая «бомба»: Неподписанные NDA, детали судебных исков, условия эксклюзивных сделок

- Ноу-хау: Исходный код ключевых алгоритмов, чертежи невыпущенных продуктов

Реальный случай: Менеджер загрузил в ChatGPT техническое задание для нового продукта, включая точные спецификации и сроки запуска. Через месяц конкурент анонсировал очень похожий продукт. Прямой связи доказать не удалось, но урок усвоен.

🟡 ЖЕЛТАЯ ЗОНА (Маскировка обязательна)

Можно использовать, только если разорвана связь с реальным миром (Data Masking).

- Планы проектов: Заменяем «Запуск для Газпрома» на «Запуск для Крупного Клиента в Энергетике»

- Проблемы и риски: Описываем ситуацию абстрактно. «Поставщик А задерживает чипы» → «Ключевой вендор срывает сроки поставок комплектующих»

- Переписка: Удаляем шапки писем, подписи и даты. Оставляем только суть конфликта или задачи

Техника маскировки:

Перед отправкой данных в ИИ скопируйте текст в Блокнот и сделайте Ctrl+H (Поиск и Замена):

- Название компании →

Company_A - Конкурента →

Competitor_B - Суммы → разделите на 1 000 или уберите валюту

- Имена сотрудников →

Employee_1,Employee_2

🟢 ЗЕЛЕНАЯ ЗОНА (Безопасно)

Общедоступные знания и структура.

- Методология: «Как рассчитать SPI/CPI?», «Создай шаблон Risk Register»

- Редактура: «Сделай этот текст более официальным» (если в тексте нет секретов)

- Публичные данные: Анализ информации, которая уже лежит на сайте компании

Примеры безопасных запросов:

- «Напиши шаблон устава проекта по PMBoK»

- «Переформулируй это письмо в более дипломатичном тоне»

- «Создай структуру WBS для проекта миграции на облако»

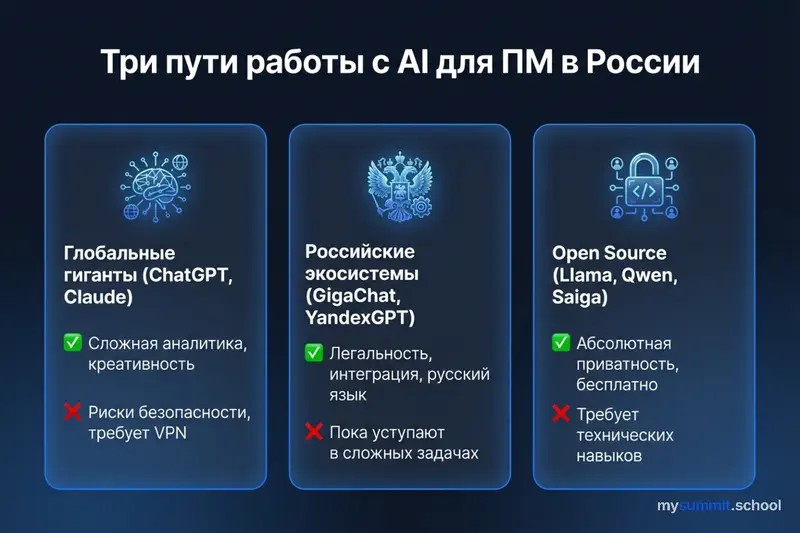

Три пути работы с AI для ПМ в России

Тренд BYOA в России сталкивается с уникальным препятствием. Если на Западе главная проблема – это корпоративная безопасность, то у нас к ней добавляются санкционные риски, сложности оплаты OpenAI/Anthropic и законодательство (152-ФЗ о хранении персональных данных).

Перед российским проектным менеджером открыты три пути. Давайте разберём, какой из них лучше справляется с тремя китами управления: Контекстом, Доступом и Знаниями.

Путь №1: Глобальные гиганты (ChatGPT, Claude, Notion AI)

Выбор «Партизана»

ПМы продолжают использовать их через VPN и зарубежные карты, потому что по качеству Actionable Knowledge (сложному логическому рассуждению) GPT-4o и Claude 3.5 Sonnet всё ещё держат пальму первенства.

Где выигрывает:

- Сложная аналитика: Если нужно проанализировать риски в запутанном ТЗ на 50 страниц, Claude 3.5 – чемпион благодаря огромному контекстному окну (200 000 токенов)

- Кодинг и скрипты: Написание макросов для Excel или скриптов для Google Sheets

- Креативность: Брейншторм идей, генерация гипотез, нестандартные решения

Где проигрывает:

- Контекст и Безопасность: Загрузка данных российского госзаказчика или крупного банка в серверы OpenAI – это «Красная зона». Это прямой риск увольнения

- Доступ: Интеграция с Jira или отечественным софтом через Zapier стала сложной и дорогой

- Нестабильность: VPN блокируются, карты перестают работать

Вердикт: Идеально для методологии («Как построить WBS?») и обезличенных данных, но опасно для реальных проектных документов.

Путь №2: Российские экосистемы (GigaChat, YandexGPT)

Выбор «Корпоративного Патриота»

Российские модели (Sber GigaChat и YandexGPT) совершили огромный скачок. Они решают главную проблему BYOA в России – легальность.

Как это решает проблему Контекста?

- GigaChat B2B: Сбер предлагает коробочные решения, где модель разворачивается в контуре банка или компании. Вы можете безопасно «скармливать» ей внутренние регламенты

- Контекст культуры: Российские модели лучше понимают наши бюрократические формулировки, специфику ГОСТов и формальный язык служебных записок

Как это решает проблему Доступа?

- Интеграция: YandexGPT уже внедряется в экосистему Яндекса (Трекер, Вики). Если ваша компания сидит на Yandex Tracker, агент получает нативный доступ к задачам без «костылей»

- Bitrix24 CoPilot: Встроенный ИИ внутри Битрикса (работает на базе GigaChat/Yandex) сразу имеет доступ к CRM и задачам. ПМу не нужно ничего настраивать

Слабые места:

- Пока ещё уступают GPT-4 в сложных многоходовых рассуждениях (Chain-of-Thought)

- Могут хуже справляться с креативными задачами на английском

- Меньше плагинов и интеграций

Вердикт: Оптимальный выбор для компаний, работающих с чувствительными данными и требующих соответствия российскому законодательству.

Путь №3: Open Source и Локальные модели (Llama 3, Qwen, Saiga)

Выбор «Техно-гика» и «Параноика»

Это самый интересный и быстрорастущий тренд. ПМ скачивает программу (например, LM Studio или Ollama) и запускает нейросеть прямо на своём рабочем ноутбуке.

Как это решает все проблемы сразу?

- Абсолютная приватность (Контекст): Вы можете загрузить в чат с локальной Llama 3 бюджет проекта с точностью до копейки, паспортные данные команды и пароли. Данные физически не покидают ваш ноутбук. Интернета может вообще не быть

- Бесплатность: Не нужно платить $20 за подписку. Нужен только хороший компьютер (желательно Mac M1/M2/M3 или ноут с видеокартой NVIDIA)

- Полный контроль: Вы выбираете модель, настраиваете параметры, дообучаете на своих данных

Какие модели использовать?

- Llama 3 (Meta) / Mistral: Отличные универсальные модели

- Qwen 2.5 (Alibaba) / DeepSeek: Китайские модели, которые сейчас (на 2024–2025 год) работают с русским языком и кодом пугающе хорошо, часто на уровне GPT-4

- Saiga (Ilya Gusev): Русскоязычная дообученная версия Llama, которая идеально понимает наш сленг и культурный код

Быстрый старт с LM Studio (5 минут):

Скачайте LM Studio:

- Перейдите на lmstudio.ai и скачайте версию для вашей ОС (Windows/Mac/Linux)

- Установите программу (размер около 500 МБ)

Выберите модель:

- Откройте вкладку «Search» (🔍)

- Для начала рекомендуем:

- На Mac M1/M2/M3 (16 GB RAM): Qwen2.5-7B-Instruct или Llama-3.1-8B

- На Windows с видеокартой NVIDIA (6+ GB VRAM): DeepSeek-R1-Distill-Llama-8B

- Если мало памяти: Выбирайте модели с пометкой

Q4_K_M(квантизированные, около 5 ГБ)

Скачайте и запустите:

- Нажмите «Download» (первая загрузка займёт 5–10 минут)

- После скачивания перейдите в «Chat» (💬)

- Выберите загруженную модель в выпадающем списке

- Готово! Можете начинать диалог

Первый тест:

- Попробуйте: «Проанализируй этот бюджет проекта [вставь таблицу]. Какие риски ты видишь?»

- Или: «Напиши короткий статус-отчёт по этим данным [вставь текст]»

Совет: Для работы с конфиденциальными данными отключите интернет перед запуском чата (Wi-Fi → выключить). Это гарантирует, что данные физически не могут утечь.

Слабые места:

- Требует базовых технических навыков для установки

- Нужен мощный компьютер (16+ GB RAM для комфортной работы)

- Модели уступают флагманам в сложных задачах

- Первая загрузка модели занимает 5–15 минут

Вердикт: Единственный способ работать с абсолютно конфиденциальными данными без риска утечки. Идеально для финансовых расчётов, анализа договоров, работы с персональными данными.

Гибридная стратегия: Светофор данных

Как ПМу выжить в этом зоопарке? Используйте подход «Светофор данных»:

🟢 Зелёная зона (Методология, Обучение, Общие вопросы):

Используйте ChatGPT/Claude через личный аккаунт. Они самые умные. Спрашивайте их: «Как лучше провести ретроспективу?», «Сделай шаблон устава».

🟡 Жёлтая зона (Рутина, Письма, Внутренние документы):

Используйте GigaChat или YandexGPT. Они безопасны с точки зрения закона (сервера в РФ), хорошо пишут по-русски и интегрированы в рабочие инструменты.

🔴 Красная зона (Деньги, Персданные, Тайны):

Установите LM Studio и скачайте модель Saiga или Qwen. Работайте с чувствительными данными локально. Это единственный способ использовать мощь ИИ для анализа финансов и договоров, не нарушая NDA и 152-ФЗ.

Что делать организации? От BYOA к Enterprise RAG

Запретить BYOA невозможно – сотрудники найдут обходные пути. Компании должны возглавить этот процесс, построив инфраструктуру, решающую те же проблемы, но безопасно.

Три шага к безопасному корпоративному AI:

1. Решение проблемы Контекста: Enterprise RAG Внедрение Retrieval-Augmented Generation – создание корпоративной векторной базы знаний, где ИИ имеет доступ к Confluence и Jira, но с учётом прав доступа сотрудника.

2. Решение проблемы Доступа: API-шлюзы Создание безопасных шлюзов API. Вместо копирования CSV, агент должен сам уметь делать SQL-запросы к базе данных через защищённый протокол (Function Calling).

3. Решение проблемы Знаний: Корпоративные подписки Покупка корпоративных подписок (ChatGPT Enterprise, Microsoft Copilot), где гарантируется, что данные не используются для обучения моделей (Zero Data Retention).

Прогноз Forrester: Компании будут вынуждены легализовать BYOA, создавая «безопасные песочницы», потому что запретить это невозможно – сотрудники просто найдут обходные пути.

Заключение

Проектный менеджер сегодня превращается в Архитектора Знаний. Использование BYOA даёт невероятное конкурентное преимущество здесь и сейчас, позволяя преодолеть бюрократию и работать быстрее. Но это временный «костыль».

Будущее – за гибридным подходом: ПМ учится правильно формировать контекст и запросы (Prompt Engineering), а организация предоставляет для этого безопасную и мощную инфраструктуру. Пока инфраструктуры нет – используйте BYOA, но не забывайте про «Красную зону».

Три ключевых вывода:

BYOA – это реальность, а не отклонение. 78% пользователей AI уже используют личные инструменты на работе. Компаниям нужно адаптироваться, а не запрещать.

Безопасность – это ваша ответственность. Используйте светофорный протокол: зелёная зона для методологии, жёлтая для рутины с маскировкой, красная зона – только локальные модели.

Российский контекст создаёт уникальные возможности. Сочетание глобальных моделей для креатива, российских для легальности и локальных для конфиденциальности – это не компромисс, а преимущество.

Что делать прямо сейчас:

- Проведите аудит ваших текущих практик работы с AI

- Определите, какие данные попадают в какую зону

- Установите локальную модель для работы с чувствительной информацией

- Обсудите с руководством легализацию AI-инструментов

Хотите научиться использовать AI безопасно и эффективно? В курсе mysummit.school мы разбираем практические кейсы BYOA, учим работать с локальными моделями и показываем, как настроить личного AI-агента под ваши задачи – без риска для компании.

Хотите использовать AI безопасно и эффективно?

В курсе mysummit.school мы разбираем практические кейсы BYOA, учим работать с локальными моделями и показываем, как настроить личного AI-агента под ваши задачи. 3 бесплатных урока включают всё, что нужно для старта.

Читайте также

Источники

- Microsoft Work Trend Index 2025: The Frontier Firm is Born — исследование о 78% пользователей AI, приносящих личные инструменты на работу

- Microsoft: AI at Work Is Here. Now Comes the Hard Part — данные о 75% knowledge workers, использующих AI

- Forrester Research: The BYOA Trend and Enterprise Strategy — прогноз о легализации BYOA

- Sierra: The Challenge with Rolling Your Own Agent — анализ проблемы “айсберга” и скрытых рисков личных AI-агентов

- Dejan.AI Workplace AI Report 2025 — исследование 1250 специалистов об использовании AI как младшего помощника