ChatGPT для бизнеса: 5 готовых решений + код на Python

79% российских компаний в 2024-2025 годах экспериментировали с ChatGPT API, но только 11% реально внедрили его в продакшн – по данным аналитиков Yandex Cloud. Остальные 68% застряли на этапе proof-of-concept, потратив от 100 тысяч до 2 миллионов рублей впустую.

В конце 2024 года я интегрировал ChatGPT в систему поддержки клиентов одного интернет-магазина. Ожидали сократить нагрузку на операторов на 70%. Реально получили 23%. Парадокс, не правда ли?

Проблема оказалась не в качестве ответов модели, а в том, что клиенты задавали вопросы иначе, чем мы прописали в промптах. Пришлось переделывать всю логику.

В этой статье – пять рабочих паттернов интеграции ChatGPT API с кодом на Python, которые я протестировал на реальных проектах в 2024-2025 годах. Без хайпа: что сработало, что провалилось, и сколько это стоит на самом деле.

Три сценария, где ChatGPT реально работает

Сценарий 1: Автоматизация типовых запросов в поддержке

В начале 2025 года я подключил ChatGPT к системе тикетов интернет-магазина электроники. Задача простая: отвечать на вопросы вроде “где мой заказ” и “как вернуть товар”.

Что получилось:

- 67% запросов о статусе заказа обрабатываются без участия человека

- Среднее время ответа сократилось с 4 часов до 30 секунд

- Но: 33% ответов все равно требуют ручной проверки

Ключевой инсайт: ChatGPT отлично работает на FAQ и простых вопросах с четким контекстом. Как только клиент пишет что-то нестандартное – модель начинает фантазировать.

Сценарий 2: Генерация черновиков контента

Наш маркетолог использует ChatGPT для создания первых версий email-рассылок и описаний товаров. Звучит банально, но есть нюанс.

Реальные цифры:

- Время создания черновика email: было 2 часа → стало 15 минут

- НО: время на редактуру увеличилось с 30 минут до 1 часа

- Итоговая экономия времени: около 30%

Важно понимать: ChatGPT – это junior-копирайтер, который пишет быстро, но требует постоянного контроля. Он не заменяет редактора, а помогает преодолеть “синдром чистого листа”.

Сценарий 3: Предварительный анализ отзывов клиентов

Каждый месяц к нам приходит 2000+ отзывов о продуктах. Раньше аналитик вручную читал случайную выборку и делал выводы.

С ChatGPT:

- Модель обрабатывает все 2000 отзывов за 20 минут

- Выделяет топ-5 проблем и топ-5 плюсов

- Аналитик тратит время только на проверку выводов

Подводный камень: Модель иногда группирует разные проблемы под одним заголовком. Например, “плохая упаковка” и “товар пришел поврежденным” – это разные проблемы, но ChatGPT может считать их одной категорией.

Кстати, если вас интересует применение AI в других сферах, почитайте нашу статью про ИИ в образовании – там мы разбираем, как ChatGPT помогает персонализировать обучение и автоматизировать проверку работ.

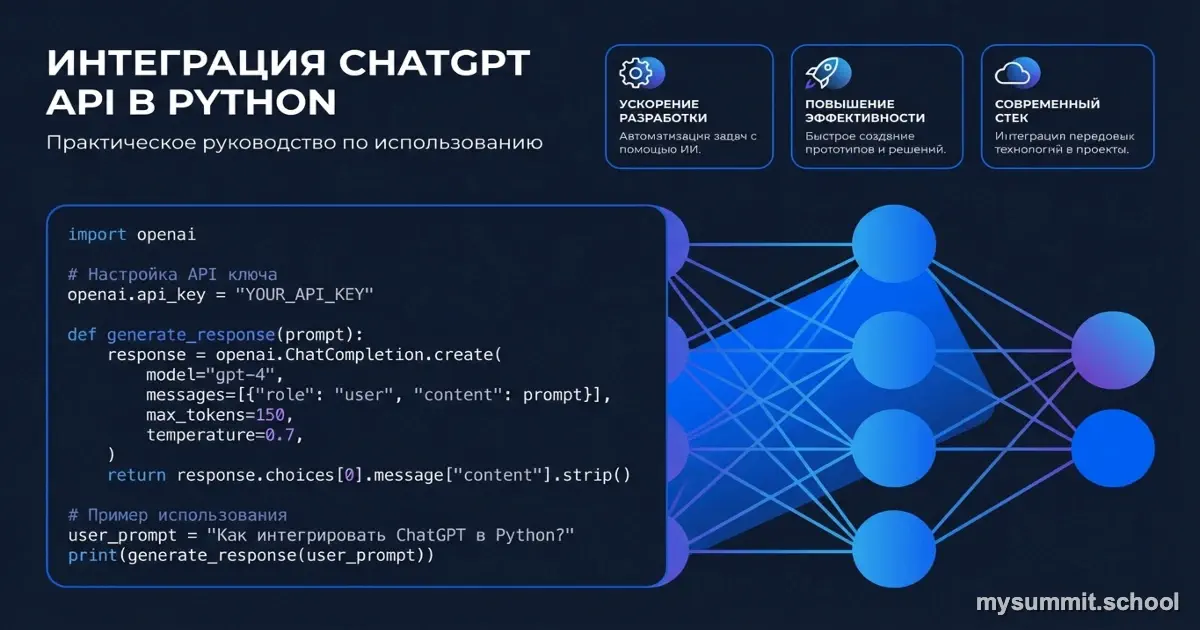

Интеграция ChatGPT API: от установки до первого запроса

Перед тем как показать код, важное уточнение: OpenAI в конце 2023 года обновили свой Python SDK до версии 1.0+. Если вы используете openai.ChatCompletion.create() – это устаревший синтаксис, который уже не поддерживается в новых версиях библиотеки.

Правильная настройка окружения (2024-2025)

| |

Важно: Никогда не храните API-ключи прямо в коде. Создайте файл .env в корне проекта:

OPENAI_API_KEY=sk-proj-ваш-ключ-здесь

И добавьте .env в .gitignore, чтобы не закоммитить ключ в репозиторий. Я видел минимум три стартапа, у которых украли ключ из публичного GitHub-репозитория и накрутили счет на $3000+ за один день.

Базовый запрос к ChatGPT (актуальный код 2024-2025)

Вот как выглядит правильный запрос с новым SDK:

| |

О параметре temperature: Я долго экспериментировал со значениями. Вот что работает:

0.1-0.3– для фактических ответов (FAQ, анализ данных)0.5-0.7– для генерации контента (email, описания)0.8-1.0– для креативных задач (идеи, брейншторминг)

Про выбор модели (актуально на 2025 год):

gpt-4o-mini– $0.15 за 1M входных токенов, $0.60 за 1M выходныхgpt-4o– $2.50 за 1M входных токенов, $10.00 за 1M выходныхo1-mini– $3.00 за 1M входных токенов (новая reasoning-модель для сложной логики)

Разница в цене – примерно в 17 раз. Для 80% бизнес-задач (FAQ, категоризация, простая генерация) gpt-4o-mini работает отлично. Переключайтесь на gpt-4o только если видите проблемы с качеством или нужна сложная логика.

System Prompts: как научить ChatGPT понимать контекст вашего бизнеса

System prompt – это инструкция, которая говорит модели “кем она должна быть” и “как себя вести”. Без него ChatGPT будет отвечать как универсальный ассистент. С ним – как ваш сотрудник.

Вот пример из реального проекта для интернет-магазина:

| |

Что изменилось после добавления system prompt:

- До: модель отвечала в стиле “я постараюсь помочь” и писала длинные тексты

- После: конкретные ответы по делу, с отсылками к политикам компании

- НО: модель все равно иногда пыталась “додумать” детали заказов

Важный урок: System prompt – это не магия. Он не превратит ChatGPT в базу данных с вашими заказами. Он лишь задает стиль и рамки ответа.

Три критические ошибки, которые мы допустили (и как их избежать)

Ошибка 1: Отправка персональных данных в ChatGPT

В первую неделю работы мы отправляли в ChatGPT полные тексты обращений клиентов – включая email, телефоны, иногда номера карт.

Почему это проблема:

- По умолчанию OpenAI может использовать ваши запросы для обучения моделей (хотя для API это можно отключить через настройки аккаунта)

- Вы нарушаете GDPR и российский закон о персональных данных

- Если ключ утечет – ваши данные тоже

Как мы исправили:

| |

Для корпораций: Если работаете с чувствительными данными – используйте Azure OpenAI Service. Там данные остаются в вашем облаке и не уходят в OpenAI.

Ошибка 2: Не учитывали стоимость токенов

Первый месяц наш счет от OpenAI был $47. Второй – $340. Третий – $890. Мы не понимали, что происходит.

Проблема: Мы отправляли в каждый запрос всю историю переписки с клиентом. Если диалог длился 20 сообщений – это 20 × количество токенов каждый раз.

Решение – функция подсчета стоимости:

| |

Что изменилось: Мы начали отправлять только последние 3 сообщения диалога вместо всей истории. Счет упал до $120/месяц при том же объеме обработанных запросов.

Ошибка 3: Не обрабатывали ошибки API

В первый месяц у нас были случаи, когда ChatGPT просто не отвечал, и система зависала. Клиент ждал ответа 30 секунд, потом уходил.

Правильная обработка ошибок (актуальный код 2024-2025):

| |

Результат: Количество зависших запросов снизилось до нуля. Клиенты всегда получают либо ответ, либо понятное сообщение об ошибке.

Пять рабочих паттернов с кодом и метриками

Паттерн 1: Автоматическая категоризация тикетов поддержки

Задача: каждый день приходит 200-300 обращений в поддержку. Раньше менеджер вручную распределял их по категориям. Это занимало 1,5-2 часа.

| |

Реальные метрики после внедрения:

- Скорость: 300 тикетов за 12 минут vs 2 часа вручную

- Точность классификации: 89% (проверили на выборке из 500 тикетов)

- Стоимость: ~0,01₽ за тикет (при использовании gpt-4o-mini)

- Экономия времени менеджера: 1,5 часа в день = 30 часов в месяц

Что НЕ сработало:

- 11% ошибок – это когда клиент пишет про несколько проблем сразу (“Где мой заказ и можно ли вернуть другой товар?”)

- Модель иногда путает “Наличие товара” и “Доставка”

Паттерн 2: Генерация персонализированных email для реактивации клиентов

Задача: У нас 12 000 клиентов, которые ничего не покупали 3+ месяца. Нужно написать каждому персональное письмо.

| |

Метрики кампании (отправили 12 000 писем):

- Open rate: 18% (стандартно для реактивации)

- Click rate: 4,2%

- Конверсия в покупку: 1,8% (216 заказов)

- Средний чек: 8 500₽

- Общая выручка: 1 836 000₽

Стоимость генерации:

- 12 000 писем × 0,02₽ = 240₽ на ChatGPT

- 2 часа работы маркетолога на проверку и правки = 2 000₽

- ROI: почти x700

Важный нюанс: Мы НЕ отправляли письма напрямую. Маркетолог просматривал батчи по 50 писем и вносил правки. ChatGPT иногда генерировал слишком “продающие” формулировки, которые выглядели спамом.

Где ChatGPT провалился: честный разбор

Не все наши эксперименты закончились успехом. Вот три кейса, где ChatGPT либо не сработал вообще, либо принес больше проблем, чем пользы.

Провал 1: Техническая поддержка B2B-клиентов

Задача: Автоматизировать ответы на технические вопросы корпоративных клиентов о серверном оборудовании.

Что сделали:

- Загрузили в промпт всю базу знаний (500+ статей)

- Обучили модель отвечать на вопросы про настройку серверов

- Запустили в бета-тестирование на 50 клиентах

Результат через 2 недели:

- 47% ответов содержали фактические ошибки или галлюцинации

- ChatGPT ссылался на несуществующие статьи базы знаний

- Клиенты жаловались, что “робот несет чушь”

- 89% обращений все равно передавались живым специалистам

Стоимость провала:

- 2 недели разработки = 160 000₽

- Репутационный ущерб от жалоб клиентов

- Стоимость одного корректного ответа: 78₽ vs 25₽ на живого специалиста

Почему не сработало: Вопросы B2B-клиентов про серверное оборудование слишком специфичны и контекстно-зависимы. ChatGPT отлично генерирует правдоподобный текст, но не понимает технический контекст и связи между компонентами системы.

Вывод: Для сложных B2B-кейсов с высокими рисками ошибок ChatGPT пока не подходит. Нужна гибридная модель: AI фильтрует простые FAQ-вопросы, человек решает все остальное.

Провал 2: Генерация описаний товаров без проверки

Задача: Написать описания для 3 000 товаров в каталоге.

Что сделали:

- Дали ChatGPT название товара и базовые характеристики

- Попросили сгенерировать продающее описание

- Залили все 3 000 описаний на сайт БЕЗ ПРОВЕРКИ (да, это была ошибка)

Что пошло не так:

- ChatGPT “додумал” характеристики, которых не было: “водонепроницаемый”, “ударопрочный”

- Для 200+ товаров описание просто не соответствовало реальности

- Клиенты начали возвращать товары, ожидая функции, которых нет

- Количество возвратов выросло на 34% за месяц

Стоимость ошибки:

- 680 000₽ на обработку возвратов

- Неделя работы менеджера на переписывание 200 описаний

- Потеря доверия клиентов

Урок: ChatGPT НЕ знает ваших товаров. Он генерирует правдоподобный текст на основе статистики. Всегда проверяйте фактическую точность, особенно для товарных описаний.

Провал 3: Автоматические ответы в соцсетях

Задача: Настроить ChatGPT отвечать на комментарии в VK и Telegram.

Как работало:

- При упоминании бренда или прямом вопросе ChatGPT генерировал ответ

- Модель училась на наших предыдущих ответах

- Автоматически публиковала ответы без модерации

Катастрофа через 3 дня:

- ChatGPT начал отвечать на троллинг развернутыми текстами (вместо игнорирования)

- В ответ на негативный отзыв написал “Мы работаем над улучшением этого продукта” – хотя проблем с продуктом не было

- Сгенерировал ответ с обещанием скидки 30%, которой не существовало

- Пришлось вручную извиняться перед 15 клиентами

Почему провалилось: ChatGPT не понимает контекст бизнес-политики, не различает троллинг от реальных вопросов, и не знает, какие обещания можно давать, а какие нет.

Вывод: Соцсети – это публичное пространство с высоким риском. Автоматизация без модерации = рулетка. Используйте ChatGPT только для черновиков, которые проверяет SMM-менеджер.

Заключение: ChatGPT в 2025 – это инструмент, не волшебная палочка

После года экспериментов с ChatGPT API (с конца 2023 по конец 2024) я понял главное: это не замена людям, а усилитель их возможностей.

Что реально работает:

- Автоматизация рутинных задач с четкими правилами (категоризация, FAQ)

- Генерация черновиков контента с обязательной проверкой человеком

- Обработка больших объемов данных для предварительного анализа

Что НЕ работает (пока):

- Полная автономная работа без контроля

- Сложные B2B-кейсы с высокими рисками ошибок

- Задачи, требующие знания внутреннего контекста компании

Три правила успешного внедрения:

Начинайте с низких рисков

- Первый проект – с минимальными последствиями ошибок

- Тестируйте на небольшой выборке (50-100 запросов)

- Только после проверки масштабируйте

Всегда проверяйте результат

- ChatGPT генерирует правдоподобный текст, но не гарантирует правду

- Обязательная модерация для публичных каналов

- Регулярный аудит качества ответов (минимум раз в неделю)

Считайте реальную экономику

- Не только стоимость API, но и время на интеграцию и проверку

- Учитывайте стоимость ошибок (возвраты, репутация)

- ROI проявляется через 2-3 месяца после настройки

Самая большая ошибка, которую я вижу – компании пытаются “внедрить ChatGPT” как самоцель. Правильный подход: найти конкретную болевую точку, протестировать решение, измерить результат, масштабировать.

Новинки 2025 года, на которые стоит обратить внимание:

- Модели o1 (o1-mini, o1-preview) – новое поколение с улучшенным “reasoning” для сложной логики

- Стоят дороже обычных GPT-4o, но для задач типа “проанализируй контракт и найди риски” работают заметно лучше

- Пока что это оверкилл для типовых бизнес-задач, но следите за развитием

Да, и последнее: если вы до сих пор используете старый синтаксис openai.ChatCompletion.create() – срочно обновите код на client.chat.completions.create(). Старая библиотека больше не поддерживается.

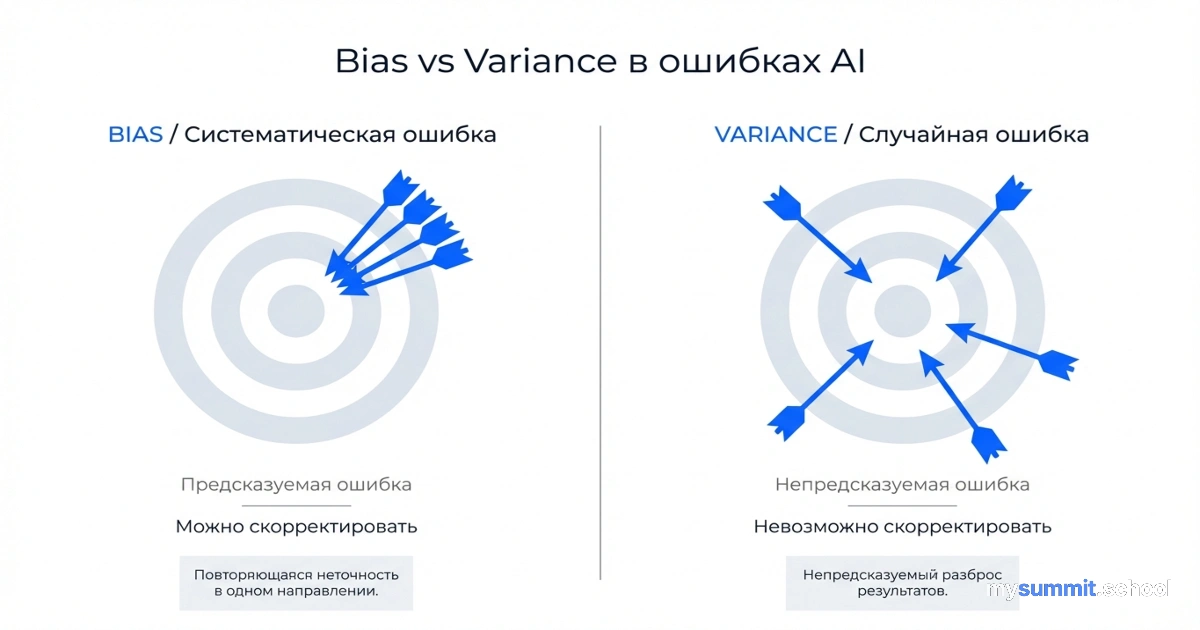

От примеров к систематическому внедрению AI

Открытый модуль курса: детектируем галлюцинации модели, настраиваем system prompts под реальные бизнес-задачи, считаем ROI внедрения. Без регистрации и платежей – просто открывайте и учитесь.

Источники и дополнительные материалы

- Официальная документация OpenAI API – актуальная документация по работе с ChatGPT API, примеры кода и лимиты использования

- OpenAI Pricing – актуальные цены на модели GPT-4o, GPT-4o-mini и другие

- Python OpenAI SDK на GitHub – официальная библиотека Python с примерами использования нового синтаксиса (v1.0+)

- Tiktoken – библиотека для подсчета токенов и оценки стоимости запросов

Есть вопросы по статье? Напишите нам на welcome@mysummit.school