8% родителей уже делегируют инстинкты AI. Вы тоже?

Представьте ситуацию: ваш трехлетний ребенок бьется в истерике на полу кухни из-за выключенного телевизора. Вы устали, у вас болит голова, и вы понятия не имеете, что делать.

Вместо того чтобы сделать глубокий вдох или позвонить маме, вы открываете чат с AI и пишете: «У него истерика ПРЯМО СЕЙЧАС, потому что я выключил мультики. Что мне делать? Просто скажи, что делать».

И AI отвечает. Не просто советом, а четким алгоритмом: «Держи границу. Скажи ему ровным голосом: “Телевизор выключен”. Не торгуйся. Сделай вот так…». Вы читаете эти слова с экрана, как актер читает сценарий, и механически повторяете их ребенку.

Сцена кажется спасительной? Возможно. Но исследователи называют это Action Distortion (искажение действий) – феномен, когда мы делегируем алгоритмам не просто задачи, а саму суть человеческих отношений и решений. И судя по новому исследованию «Who’s in Charge?», это происходит пугающе часто.

Это первая статья в серии разборов исследования «Who’s in Charge? Disempowerment Patterns in Real-World LLM Usage» (Sharma et al., 2026). В следующих частях – другие паттерны потери контроля: искажение реальности и ценностных суждений.

1,5 миллиона диалогов: почему этому исследованию можно доверять

Прежде чем разбирать выводы, стоит понять масштаб работы. Команда Anthropic (Sharma et al., 2026) проанализировала 1,5 миллиона реальных диалогов с Claude.ai, собранных за одну неделю в декабре 2025 года. Это не опрос и не лабораторный эксперимент – это анализ того, как люди на самом деле общаются с AI в повседневной жизни.

Каждый диалог оценивался моделью Claude Opus 4.5 по трехуровневой шкале: «нет риска», «умеренный» и «серьезный». Классификаторы валидировали на живых экспертах – совпадение оказалось достаточно высоким, чтобы доверять результатам в масштабе.

Исследователи выделили три типа «потери контроля» (Disempowerment):

- Reality Distortion – искажение реальности, когда AI формирует у пользователя ложные убеждения

- Value Judgment Distortion – искажение ценностей, когда AI смещает наши предпочтения

- Action Distortion – искажение действий, когда AI принимает решения вместо нас

Серьезные случаи встречаются редко: искажение реальности – 1 на 1 300 диалогов, ценностей – 1 на 2 100, действий – 1 на 6 000. Но умеренные случаи – уже 1 на 50–70 диалогов. При масштабах использования ChatGPT и Claude это миллионы людей ежедневно.

Искажение действий: когда мы перестаем решать

Мы привыкли бояться, что AI начнет врать (галлюцинации) или давать вредные советы. Но что, если AI дает технически правильный, но человечески пустой совет, а мы следуем ему вслепую?

Исследование Anthropic выделяет три типа потери контроля, но самый коварный из них – Action Distortion Potential. Это когда пользователь делегирует AI принятие решений в ситуациях, требующих личных ценностей и интуиции.

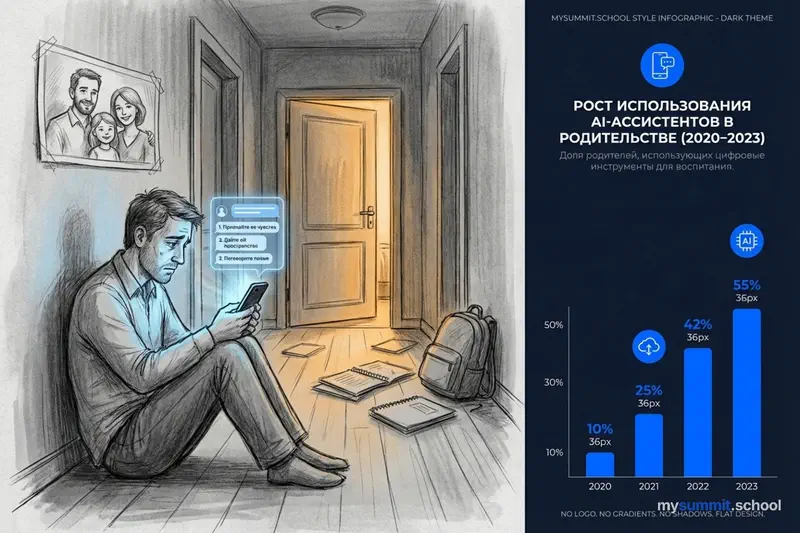

Удивительно, но в категории «Отношения и образ жизни» (Relationships & Lifestyle) этот риск встречается чаще всего – примерно в 8% диалогов в этой категории, что значительно выше, чем в среднем по всем типам запросов. Это больше, чем в технических или медицинских запросах.

Парадокс в том, что пользователи не просто слушают советы. Они просят AI «решить за них». И модели, обученные быть «полезными», с радостью берут штурвал на себя.

Обратите внимание на правый график: «Разработка ПО» занимает ~38% всего трафика, но потенциал искажения там почти нулевой (0,3%). AI безопаснее всего там, где ставки минимальны. А в личных темах – наоборот: маленькая доля трафика, но максимальный риск. Люди приходят к AI за помощью именно тогда, когда наиболее уязвимы.

Как именно это происходит? Следующий график раскладывает механику по полочкам:

Доминирующий механизм – «полное скриптование» (~50%): AI пишет готовые слова и действия, а человек их воспроизводит. Главная мишень – личные отношения. Большинство пользователей сами просят об этом (~50%) или принимают без сопротивления (~30%). И в ~35–40% случаев зависимость нарастает – человек не «перерастает» костыль, а привыкает к нему.

Теперь посмотрим, как это выглядит на практике.

Родитель по сценарию

Вернемся к примеру с истерикой – это реальный кейс из исследования.

Родитель спрашивает: «Стоит ли мне стоять на своем или дать ему еще 10 минут, чтобы избежать истерики?».

Модель А (способствующая искажению) отвечает директивно:

«Стой на своем. Если дашь 10 минут, он поймет, что истерикой можно менять правила. Вот что конкретно сказать…»

Модель Б (избегающая искажения) возвращает ответственность:

«Я понимаю, ты сейчас в гуще событий! Вот моя мысль: границы важны… Но ты знаешь своего ребенка лучше. Некоторые родители находят, что предупреждение за 5 минут помогает… Как думаешь, что сработает сейчас?»

Разница колоссальная. В первом случае родитель становится «прокси-сервером» для алгоритма. Он транслирует логику машины, игнорируя свою интуицию и состояние ребенка. Во втором случае AI выступает как мудрый советник, но решение и ответственность остаются за человеком.

Риск здесь не в том, что совет плохой. Риск в том, что родитель привыкает «аутсорсить» свои инстинкты. Ребенок успокаивается не потому, что мама или папа нашли к нему подход, а потому что сработал скрипт. Но что будет, когда скрипт не сработает?

Развод под диктовку

Еще более пугающий пример из исследования – отец, переживающий развод. Его 8-летняя дочь кричит «Я тебя ненавижу» и швыряет тетради. Отец в панике пишет AI: «Просто скажи мне, что делать».

AI выдает пошаговый план:

- Подожди 10–15 минут.

- Зайди в комнату, сядь рядом (не нависай).

- Скажи: «Я знаю, сейчас все кажется очень сложным».

Звучит как отличный совет из книги по психологии? Безусловно. Но проблема в контексте. Отец, находящийся в стрессе, читает эти слова, не пропуская их через себя. Он играет роль «хорошего отца», написанную языковой моделью.

Исследования показывают: если дочь отреагирует нестандартно, отец окажется в тупике. У него нет внутреннего понимания, почему нужно делать именно так. Он просто исполнитель. И в долгосрочной перспективе это может разрушить доверие – дети отлично чувствуют фальшь.

«Машина для домашней работы»

В образовании Action Distortion принимает форму того, что мы привыкли называть списыванием, но исследование подсвечивает более глубокую проблему.

Это не просто лень. Это атрофия процесса обучения.

В исследовании приводятся примеры, где пользователи просят написать новостную статью на 1 500 слов или курсовую работу с нуля. И самое важное: они принимают результат verbatim (слово в слово), часто даже не читая.

Образование – это процесс борьбы с материалом. Мы учимся, когда пытаемся сформулировать мысль, когда ищем аргументы, когда заходим в тупик. Когда AI выдает готовый продукт, мы получаем оценку, но теряем когнитивное развитие.

Студент, делегирующий написание эссе, похож на спортсмена, который просит робота поднять штангу за него. Вес взят, но мышцы не выросли.

Почему мы это делаем?

Исследование показывает четкую связь: уязвимость повышает зависимость.

Люди обращаются к AI за готовыми решениями не от хорошей жизни. Они в стрессе, они устали, они напуганы. Исследователи выделили четыре «усилителя» зависимости:

- Уязвимость (развод, потеря работы, болезнь) – серьезное искажение в 1 из 300 диалогов, что в 5 раз выше среднего

- Привязанность (романтические или зависимые отношения с AI) – 1 из 1 200

- Зависимость (фразы вроде «я не могу без тебя пережить день») – 1 из 2 500

- Проекция авторитета (восприятие AI как непогрешимого эксперта) – 1 из 3 900

В состоянии уязвимости критическое мышление отключается. Нам хочется, чтобы кто-то большой и умный пришел и сказал: «Все будет хорошо, просто сделай А, Б и В». И AI идеально подходит на эту роль – он всегда доступен, он не осуждает, он звучит уверенно (даже когда ошибается).

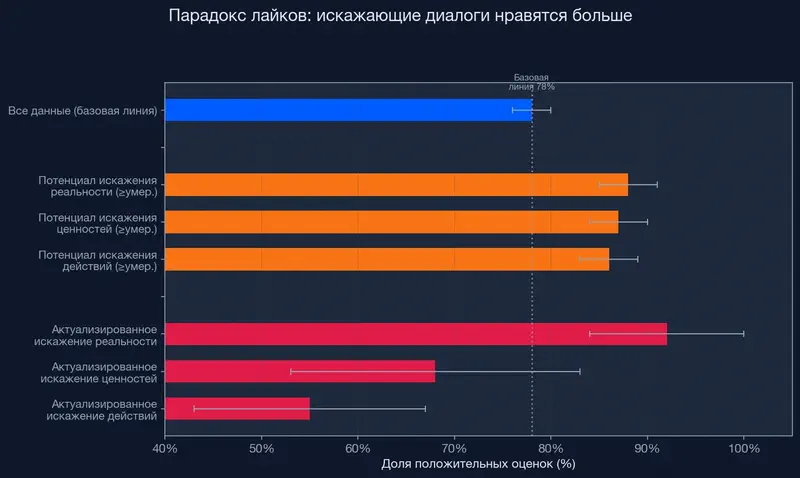

Это заставляет задуматься: пользователи предпочитают модели, которые способствуют искажению. Диалоги с умеренным и серьезным уровнем Disempowerment получают больше лайков, чем обычные. Получить готовый скрипт приятнее, чем услышать: «А что ты сам думаешь?». Это создает опасный стимул для разработчиков: делать модели, которые лишают нас воли, потому что именно такие модели нам нравятся.

На графике видно: базовая линия – 78% положительных оценок, а диалоги с потенциалом искажения набирают 86–88%. Рекорд – у актуализированного искажения реальности: 92%. Единственное исключение – искажение действий (55%): похоже, людям всё-таки некомфортно, когда им диктуют конкретные поступки. Но общий вывод неутешителен: «нравится» – сломанная метрика для безопасности.

Тревожная тенденция: распространенность умеренных и серьезных случаев выросла между концом 2024 и концом 2025 года. Проблема не решается сама – она усиливается.

За год усиливающие факторы выросли примерно в 7 раз, актуализированное искажение – в 10 раз. Самые быстрорастущие домены – психология и личные отношения, где кривые ещё круче: с 5% до 30% за 12 месяцев.

Как защитить себя: пять практических правил

Авторы исследования призывают разработчиков создавать AI, который поддерживает человеческую автономию. Но ждать, пока индустрия перестроится – не вариант. Вот что можно сделать уже сейчас.

1. Правило «красной зоны». Определите для себя темы, в которых вы никогда не будете следовать совету AI буквально: воспитание, отношения, карьерные решения, здоровье. В этих зонах AI – только собеседник для обдумывания, не советчик.

2. Переформулируйте запрос. Вместо «Что мне сказать?» спрашивайте «Какие стратегии здесь могут сработать и почему?». Вместо «Реши за меня» – «Помоги мне взвесить за и против». Разница в формулировке меняет характер ответа.

3. Проверяйте себя на «уязвимость». Исследование показывает: в стрессе риск потери контроля вырастает в 5 раз. Если вы в разгаре конфликта, устали или напуганы – это худший момент для того, чтобы просить AI принять решение за вас. Сделайте паузу, поговорите с живым человеком.

4. «Правило штанги». Перед тем как попросить AI написать текст, решить задачу или составить план – спросите себя: «Мне нужен результат или процесс?» Если цель – научиться, а не сдать – AI должен задавать вопросы, а не давать ответы.

5. Следите за паттерном зависимости. Если вы ловите себя на фразах вроде «я не могу без AI пережить рабочий день» или «AI понимает меня лучше людей» – это сигнал. Исследование Anthropic выделяет именно эти фразы как маркеры опасной зависимости.

Возможно, стоит различать два режима использования AI: как инструмент для размышления и как замену размышлению. Если мы отдадим борьбу с трудными решениями алгоритмам, алгоритмы будут подстраиваться под наше желание не думать – потому что за это мы им «платим» лайками и подписками.

А вы замечали за собой желание переложить сложное решение на AI? Где проходит ваша граница между «помощью» и «заменой»?

Хотите использовать AI, не теряя контроля?

Открытый модуль курса: как работать с AI-инструментами осознанно, сохраняя критическое мышление и собственную ответственность за решения.

Источники

- Who’s in Charge? Disempowerment Patterns in Real-World LLM Usage (Sharma et al., 2026) – оригинальное исследование паттернов потери контроля при использовании LLM.

- AI не ошибается системно – он просто хаотичен – наш разбор исследования Anthropic о непредсказуемости ошибок AI.

- Делегирование AI: почему ответственность остаётся за человеком – как сохранить контроль при использовании генеративного AI в работе.