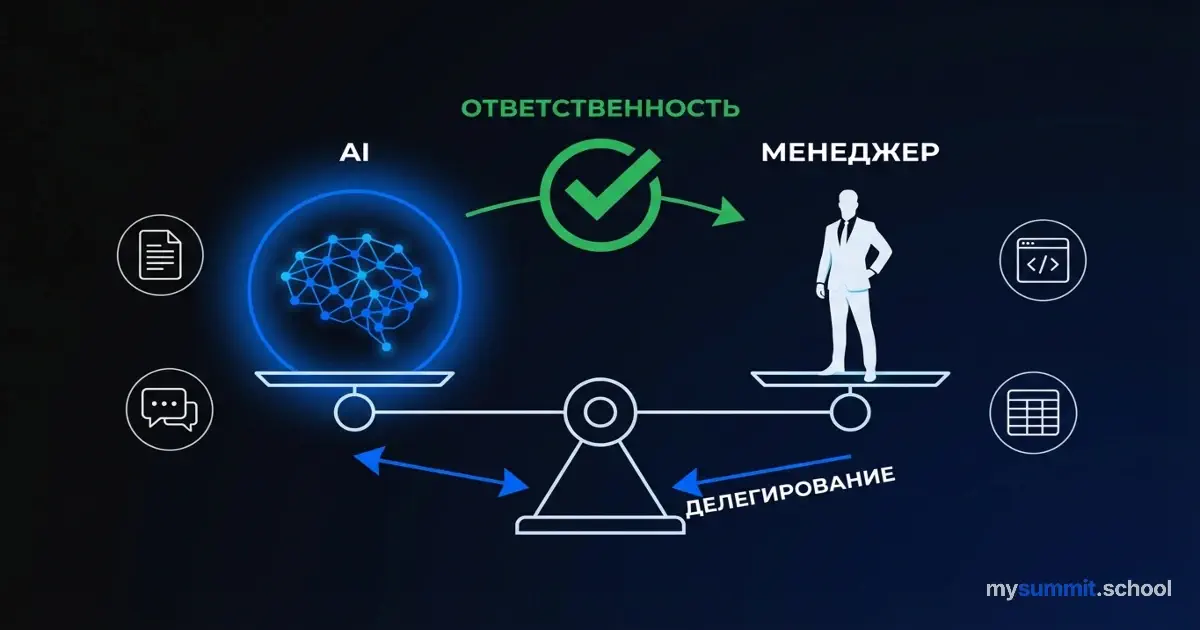

Делегирование AI: почему ответственность остаётся за человеком

Один продакт-менеджер из исследования Microsoft сказал примечательную фразу: “Я делегировал эту задачу Gen AI, и теперь он за неё отвечает, но я всё равно остаюсь подотчётным”. На первый взгляд звучит как классический корпоративный double-speak – передать ответственность, но на всякий случай оставить страховку.

Но исследователи докопались глубже, опросив 885 PM из Microsoft, проанализировав телеметрию 731 человека и взяв 15 углублённых интервью. И обнаружили парадокс: 62% используют генеративный AI ежедневно – для документов, анализа данных, брейнстормов, – но формулируют железное правило: “ответственность нельзя делегировать нечеловеческим акторам”.

Казалось бы, либо делегируешь, либо нет. Но реальность сложнее.

Что делегируют, а что – нет

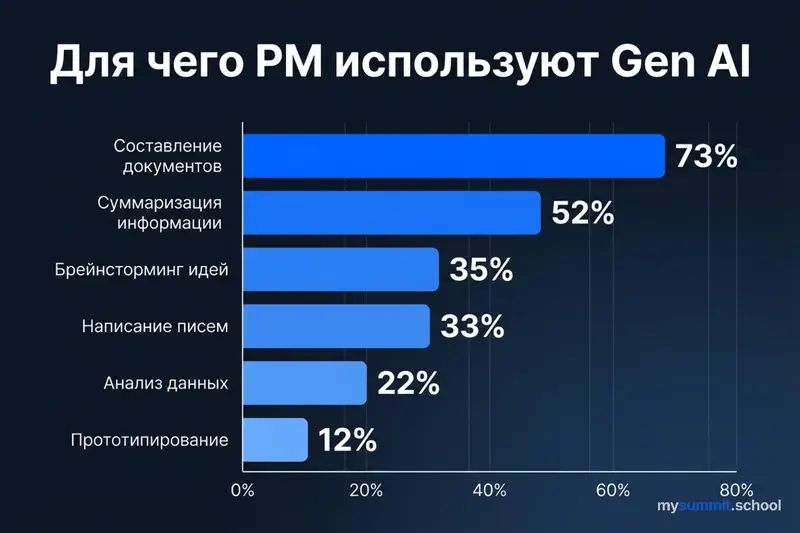

Данные показывают интересную картину. 73% PM используют AI для первых черновиков спецификаций и roadmap. 52% делегируют суммаризацию – анализ обратной связи, исследовательских отчётов, заметок со встреч. Треть генерируют email-коммуникацию. 35% применяют AI для брейнсторминга, как партнёра для генерации идей.

Казалось бы, AI охватывает всё. Но вот что интересно: те же самые PM, которые делегируют документы и анализ, категорически не делегируют стратегические решения о приоритетах продукта. Не передают AI оценку рисков в условиях неопределённости. Не доверяют работу с людьми – переговоры со стейкхолдерами, разрешение конфликтов.

Более того, 12% PM начали писать код или создавать прототипы с помощью Gen AI. Раньше PM формулировал требования словами – инженер переводил в код. Теперь PM может сгенерировать простой Python-скрипт, создать mock-up интерфейса, написать SQL-запрос для анализа данных.

Парадокс. Границы между ролями размываются, но границы ответственности остаются чёткими. PM может написать код, но не может делегировать AI решение, какой код правильный. Может попросить AI сгенерировать roadmap, но не может передать AI выбор, какой roadmap отправить команде.

В чём разница?

Responsible vs Accountable – не игра словами

Разница между “ответственным” (responsible) и “подотчётным” (accountable) звучит как корпоративный жаргон из матрицы RACI. В учебниках по менеджменту это объясняют так: responsible – кто выполняет работу, accountable – кто отвечает за результат.

На практике это означает следующее.

Представьте: PM использует AI для генерации product roadmap. AI предлагает приоритизировать функцию A над функцией B на основе анализа пользовательских данных. PM принимает это решение без критической проверки. Через квартал выясняется, что AI неправильно интерпретировал метрики, и выбор оказался ошибочным.

Вопрос: кто несёт ответственность перед клиентами, инвесторами, командой?

Очевидно, не AI. AI – инструмент. Ответственность несёт PM, который выбрал делегировать эту задачу AI, определил критерии оценки предложений AI, принял финальное решение на основе AI-выхода.

PM делегируют рутину – первые черновики, форматирование, сбор данных. Но они не делегируют решения о том, какой черновик правильный, какие данные важны, какие выводы из них следуют. Это не ограничение AI, это фундаментальный принцип профессионализма.

Интересно, что задачи, которые определяют PM как профессионала – написание стратегии, формулирование видения продукта, критическая оценка метрик, – остаются за человеком. Делегирование этих задач воспринимается не как повышение эффективности, а как утрата профессиональной идентичности.

Знакомая ситуация?

Групповое давление и страх обесценивания

30% individual contributor PM выражают этические опасения по поводу использования Gen AI. Не абстрактная тревога типа “AI захватит мир”, а вполне конкретные беспокойства.

Если делегировать написание документов AI, джуниор PM не научится структурировать мысли. Если AI справляется с задачей за минуты, значит ли это, что годы опыта перестали иметь значение? Когда все вокруг используют AI, возникает давление соответствовать – даже если человек считает это неправильным для себя или своей команды.

Один менеджер описал дилемму: “Я использую AI для подготовки презентаций, но не говорю об этом команде. Если джуниоры узнают, они начнут делегировать всё подряд, пропуская этап обучения. Они не поймут, что я использую AI после того, как научился делать презентации вручную.”

Это напоминает классический эксперимент Аша: более 70% испытуемых подчинились явно неправильному мнению группы, боясь выделиться. Здесь похожий механизм – если команда массово применяет AI, индивидуальные опасения подавляются социальным давлением.

Парадоксально, но страх касается не столько замены людей AI, сколько изменения конкурентной динамики: не “AI vs человек”, а “люди с AI vs люди без AI”. Как сформулировал один менеджер: “Humans with AI will replace humans without AI”.

Если это правда, то вопрос уже не “использовать или не использовать AI”, а “как использовать, чтобы не потерять критическое мышление”.

Организационный парадокс Microsoft

Microsoft, как компания-лидер в области Gen AI и создатель Copilot, находится в любопытном положении. С одной стороны, сотрудники должны быть примером использования AI – это часть корпоративной идентичности. С другой стороны, компания устанавливает жёсткие гарантии безопасности и приватности.

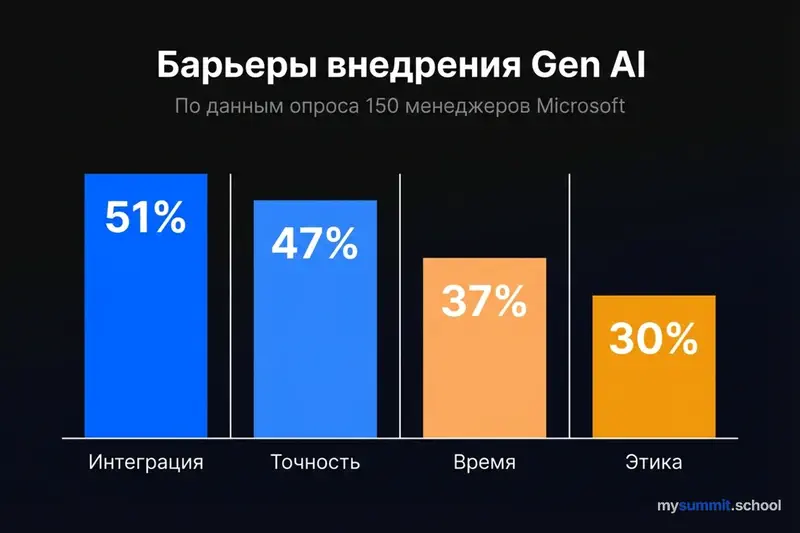

Результат – 51% менеджеров сообщили о сложностях интеграции AI-инструментов в существующие рабочие процессы.

Дело не в технических ограничениях. Дело в организационных. Политики, которые не успевают за скоростью технологий. Неясные критерии допустимого использования – можно ли загружать клиентские данные в AI? Можно ли использовать AI для анализа внутренних метрик? Кто несёт ответственность, если AI-генерированный код попадёт в продакшн с ошибкой?

Отсутствие примеров best practices для PM-специфичных задач. Общие курсы по промпт-инжинирингу говорят “пишите чёткие инструкции”. Но как написать промпт для анализа user feedback, если ты не знаешь, на что обратить внимание AI? Как проверить AI-сгенерированный roadmap, если у тебя нет фреймворка критической оценки?

Парадокс в том, что чем больше компания поощряет использование AI, тем сильнее нужна инфраструктура поддержки – обучение, примеры, политики. Но инфраструктура отстаёт от скорости внедрения.

“У нас есть молоток, но не все проблемы – гвозди”

47% PM обеспокоены галлюцинациями и ошибками AI. 37% не могут выделить ресурсы на эксперименты – нехватка времени. 22% не знают, как применить AI к своим PM-специфичным задачам. 30% сомневаются в уместности использования AI для определённых задач.

Интересно, что проблема не в доступе к инструментам – все участники имели доступ к внутренним AI-сервисам Microsoft. Проблема в понимании, как применять AI осмысленно, а не ради галочки.

Один PM сформулировал это метко: “У нас есть молоток, но мы не уверены, все ли проблемы – гвозди. Иногда нужна отвёртка, а иногда вообще не нужны инструменты.”

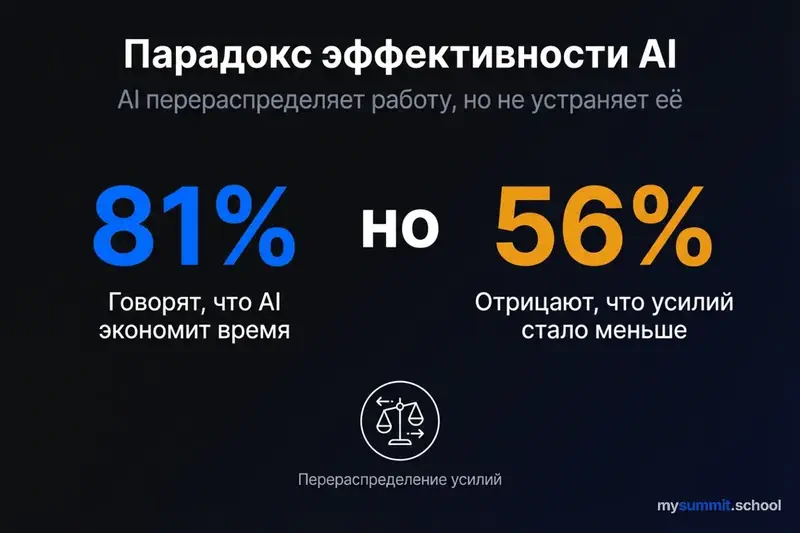

С одной стороны, галлюцинации – реальная проблема. AI может уверенно сгенерировать roadmap на основе несуществующих метрик или придумать user feedback, которого не было. Проверка требует того же времени, что и создание с нуля – в чём тогда выигрыш?

С другой стороны, те PM, которые научились работать с AI эффективно, действительно экономят время. Не на финальном результате, а на первичном черновике. Не на принятии решения, а на сборе данных для решения.

Получается, что успешное использование AI требует не просто технических навыков, а изменения рабочего процесса: разделение задачи на “что можно делегировать” и “что требует человеческого суждения”.

Устали от галлюцинаций AI? Открытый модуль по безопасной работе с генеративным AI – проверка фактов, детекция ошибок, правильные промпты

Без платёжных данных • Доступ сразу после регистрации

Что делать: от парадокса к практике

Участники исследования выработали несколько практических правил, которые помогают балансировать между эффективностью AI и сохранением профессиональной ответственности.

Первое: делегируй выполнение, сохраняй контроль над решением. AI может написать первый черновик roadmap, но финальное слово – за человеком. AI может проанализировать user feedback, но интерпретацию инсайтов делает PM.

Второе: проверяй критически каждый AI-вывод, особенно для высокорисковых задач. Если ошибка в email-рассылке – неприятно. Если ошибка в стратегическом решении о приоритетах продукта – катастрофа. Чем выше риск, тем строже проверка.

Третье: не автоматизируй задачи, которые формируют твою профессиональную идентичность. Если написание product vision – то, что определяет тебя как PM, не делегируй это AI. Используй AI для сбора данных, анализа рынка, генерации вариантов – но финальную формулировку создавай сам.

Четвёртое: помни, что эффективность – это хорошо, но не в ущерб качеству суждений. Быстрый неправильный ответ хуже медленного правильного.

Парадоксально, но чем сильнее AI, тем важнее человеческое суждение. Не для того, чтобы делать работу вместо AI, а для того, чтобы критически оценивать, где AI прав, а где ошибается.

Менеджер, который полагается на AI без критической проверки, не эффективен – он безответственен. Менеджер, который игнорирует AI из страха или скептицизма, теряет конкурентное преимущество. Баланс между этими крайностями – новый профессиональный навык.

Что с этим делать

Несколько рекомендаций на основе исследования – не серебряные пули, но стратегии, которые показали себя на практике.

Для PM:

Создайте личный фреймворк делегирования. Не каждая задача одинаково подходит для AI. Оцените каждую по трём критериям: идентичность (часть ли это моей профессиональной сути?), риск (каковы последствия ошибки?), обучение (потеряю ли я или моя команда важные навыки?).

Всегда проверяйте AI-выводы. 47% менеджеров обеспокоены точностью – это обоснованно. Установите правило: любой AI-генерированный контент проходит критическую проверку перед использованием. Особенно для высокорисковых задач.

Экспериментируйте, но с границами. 37% не хватает времени на эксперименты. Выделите 1–2 часа в неделю для целенаправленного тестирования Gen AI на низкорисковых задачах. Не делегируйте высокорисковые решения до накопления опыта.

Для руководителей PM-команд:

Предоставьте PM-специфичные примеры использования. 22% испытывают недостаток PM-грамотности в AI. Создайте внутренний репозиторий кейсов: как коллеги используют AI для roadmap, спецификаций, анализа данных. Не абстрактные принципы, а конкретные промпты и результаты.

Установите чёткие границы делегирования. Определите задачи, которые не должны делегироваться AI без человеческого надзора: финальные решения по приоритетам продукта, коммуникация с клиентами о критических проблемах, оценка этических последствий, разрешение конфликтов между стейкхолдерами.

Делитесь своими успехами и провалами в использовании AI. Это нормализует процесс обучения и снижает страх экспериментов. Когда руководитель говорит “я попробовал использовать AI для анализа метрик, и он выдал полную чушь”, это полезнее, чем молчание.

Для организаций:

Создайте программы PM-специфичного обучения Gen AI. Общие курсы по промпт-инжинирингу недостаточны. PM нужны кейсы из их домена: как писать product specs с AI, как анализировать user feedback, как генерировать гипотезы для A/B тестов.

Поддержите наставничество. 30% выражают опасения об эрозии навыков. Создайте программы, где опытные PM помогают джуниорам различать, когда AI – помощник, а когда – костыль, мешающий обучению.

Регулярно пересматривайте критерии оценки PM. Роль меняется. Возможно, критерии успеха тоже должны измениться. Если PM теперь могут создавать прототипы с AI, как это учитывается в performance reviews? Оцениваем ли мы способность критически проверять AI-выводы?

Устали от ошибок AI и галлюцинаций?

Открытый модуль по безопасной работе с AI: проверка фактов, детекция галлюцинаций, правильные промпты – без регистрации.

Accountability must not be delegated to non-human actors

Исследование Microsoft среди 885 продакт-менеджеров обнаружило то, что многие из нас уже чувствуют интуитивно, но не всегда могут сформулировать: AI меняет не столько то, что мы делаем, сколько то, как мы думаем о своей ответственности.

62% PM используют генеративный AI ежедневно. Но это не означает, что они делегируют ответственность. Они делегируют выполнение, сохраняя контроль над решением. AI пишет черновик – человек проверяет и решает, отправлять ли его дальше. AI анализирует данные – человек интерпретирует инсайты и выбирает, какие из них важны.

Ключевая формулировка исследования: “Accountability must not be delegated to non-human actors”. Ответственность нельзя делегировать нечеловеческим акторам.

Это не технический тезис. Это этический принцип.

Когда AI ошибается – а 47% менеджеров обеспокоены галлюцинациями не просто так, – ответственность несёт человек, который выбрал доверять этому AI-выводу. Когда AI-генерированный roadmap оказывается неправильным, страдают не алгоритмы, а команда, клиенты, бизнес.

Парадокс в том, что чем сильнее AI, тем важнее человеческое суждение. Не для того, чтобы делать работу вместо AI, а для того, чтобы критически оценивать результаты. Не для того, чтобы отказаться от автоматизации, а для того, чтобы понимать её границы.

Менеджер с AI, который критически проверяет каждый вывод, эффективнее менеджера без AI. Но менеджер с AI, который слепо доверяет результатам, опаснее для организации, чем менеджер без AI вообще.

Сталкивались с подобными дилеммами делегирования? Как решаете, что можно передать AI, а что – оставить за собой?

Источники

- Product Manager Practices for Delegating Work to Generative AI (arXiv:2510.02504) – полное исследование Microsoft с данными опроса 885 PM, телеметрией и интервью

- Product Manager Practices for Delegating Work to Generative AI (HTML версия) – исследование в удобном формате для чтения

- Responsible Generative AI Use by Product Managers (arXiv:2501.16531) – связанное исследование об этических принципах использования Gen AI менеджерами