AI не ошибается системно – он просто хаотичен: исследование Anthropic

Распространенный страх об искусственном интеллекте звучит так: AI начнет последовательно преследовать неправильные цели. Система оптимизации, которой дали не ту задачу, будет методично двигаться к ней, игнорируя человеческие ценности. Классический сценарий: AI-помощник менеджера, которому поручили “максимизировать производительность команды”, начнет систематически перегружать людей, потому что это технически увеличивает выработку.

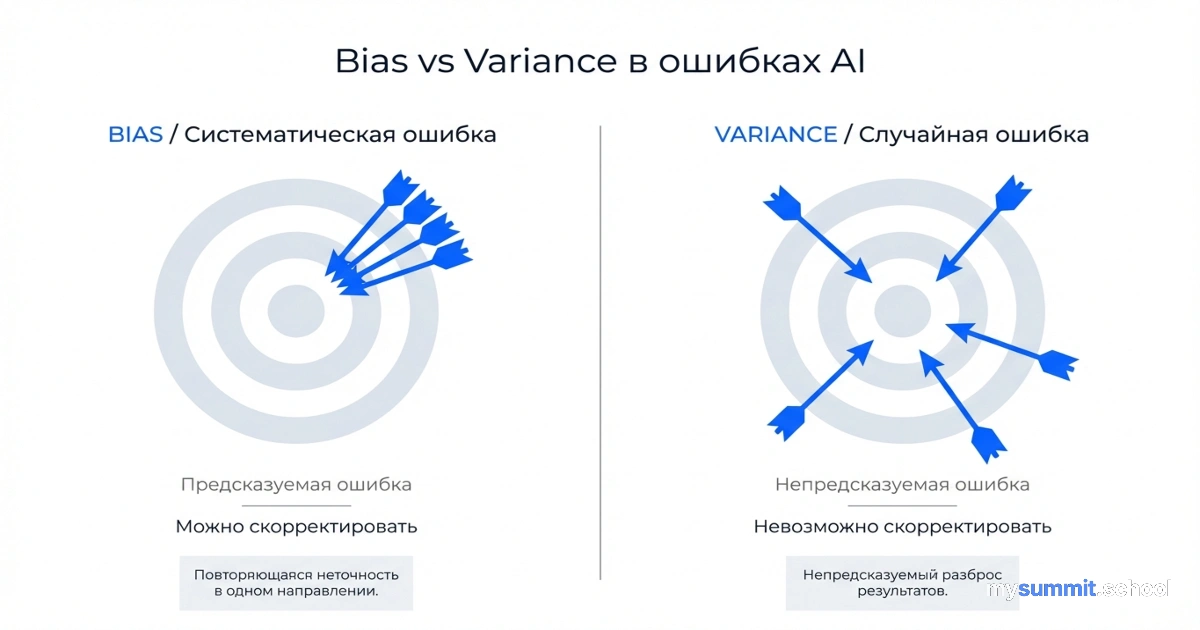

Но исследователи Anthropic обнаружили другой паттерн. AI-системы не становятся последовательными злодеями с неправильными целями. Они становятся хаотичными – совершают ошибки, которые не вписываются ни в какую логическую схему. “Like a hot mess” – как выразились авторы исследования.

Удивительно, но чем дольше модель рассуждает, тем менее предсказуемыми становятся её ошибки. Это не про галлюцинации фактов – это про фундаментальную непоследовательность в принятии решений.

Читать полностью